前言

像 Apache Lucene 这样的全文搜索引擎是为应用程序添加高效的自由文本搜索功能的非常强大的技术。但是,Lucene 在处理对象域模型时存在几个不匹配之处。除其他事项外,必须保持索引的最新状态,并且必须避免索引结构和域模型之间的不匹配以及查询不匹配。

Hibernate Search 解决了这些缺点:它借助于一些注释来索引您的域模型,负责数据库/索引同步,并从自由文本查询中带回常规的托管对象。

为了实现这一点,Hibernate Search 结合了 Hibernate ORM 和 Apache Lucene/Elasticsearch/OpenSearch 的强大功能。

1. 兼容性

1.1. 依赖项

版本 |

注意 |

|

|---|---|---|

Java 运行时 |

11、17 或 21 |

|

Hibernate ORM(用于 Hibernate ORM 映射器) |

6.6.0.Final |

|

Jakarta Persistence(用于 Hibernate ORM 映射器) |

3.1 |

|

Apache Lucene(用于 Lucene 后端) |

9.11.1 |

|

Elasticsearch 服务器(用于 Elasticsearch 后端) |

7.10+ 或 8.x |

大多数旧的次要版本(例如 7.11 或 8.0)不会优先考虑错误修复和新功能。 |

OpenSearch 服务器(用于 Elasticsearch 后端) |

1.3 或 2.x |

其他次要版本可能有效,但不会优先考虑错误修复和新功能。 |

|

如果您从 Maven 获取 Hibernate Search,建议将 Hibernate Search BOM 作为依赖项管理的一部分导入,以使所有其工件版本保持一致 |

|

Elasticsearch 7.11+ 许可

虽然 Elasticsearch 7.10 之前是根据 Apache 许可证 2.0 发布的,但请注意,Elasticsearch 7.11 及更高版本是根据 Elastic 许可证和 SSPL 发布的,它们 不被开源计划视为开源。 只有 Hibernate Search 依赖的低级 Java REST 客户端仍然是开源的。 |

|

OpenSearch

虽然它历史上针对的是 Elastic 的 Elasticsearch 发行版,但 Hibernate Search 也与 OpenSearch 兼容,并定期针对它进行测试;有关更多信息,请参见 兼容性。 本文档中所有引用 Elasticsearch 的部分也适用于 OpenSearch 发行版。 |

1.2. 框架支持

1.2.1. Quarkus

Quarkus 为使用 Elasticsearch 后端 的 Hibernate Search 与 Hibernate ORM 提供了官方扩展,这是一种与其他功能、不同依赖项和不同配置属性紧密集成的扩展。

作为在 Quarkus 中使用 Hibernate Search 的第一步,我们建议您遵循 Quarkus 的 Hibernate Search 指南:它是对 Hibernate Search 的极好的实践介绍,并且它涵盖了 Quarkus 的具体细节。

1.2.2. WildFly

WildFly 包含用于使用 Lucene 后端 或 Elasticsearch 后端 的 Hibernate Search 与 Hibernate ORM 的模块。

要开始在 WildFly 中使用 Hibernate Search,请参见 WildFly 开发者指南中的 Hibernate Search 部分:它涵盖了 WildFly 的所有具体细节。

1.2.3. Spring Boot

Hibernate Search 可以轻松地集成到 Spring Boot 应用程序中。只需阅读以下关于 Spring Boot 的具体细节,然后按照 入门指南 进行操作。

配置属性

application.properties/application.yaml 是 Spring Boot 配置文件,而不是 JPA 或 Hibernate Search 配置文件。在该文件中直接添加以 hibernate.search. 开头的 Hibernate Search 属性将不起作用。

- 当 将 Hibernate Search 与 Hibernate ORM 集成 时

-

使用

spring.jpa.properties.作为 Hibernate Search 属性的前缀,以便 Spring Boot 将这些属性传递给 Hibernate ORM,Hibernate ORM 会将它们传递给 Hibernate Search。例如

spring.jpa.properties.hibernate.search.backend.hosts = elasticsearch.mycompany.com - 当使用 独立 POJO 映射器 时

-

您可以将属性以编程方式传递给

SearchMappingBuilder#property。

依赖项版本

Spring Boot 会在您不知情的情况下自动设置依赖项的版本。虽然这通常是件好事,但有时 Spring Boot 依赖项会稍微过时。因此,建议至少为一些关键依赖项覆盖 Spring Boot 的默认值。

使用 Maven,有几种方法可以覆盖这些版本,具体取决于将 Spring 添加到应用程序的方式。如果您的应用程序的 POM 文件使用 spring-boot-starter-parent 作为其父 POM,那么只需将版本属性添加到您的 POM 的 <properties> 中即可。

<properties>

<hibernate.version>6.6.0.Final</hibernate.version>

<elasticsearch-client.version>8.15.0</elasticsearch-client.version>

<!-- ... plus any other properties of yours ... -->

</properties>|

如果在设置了上面的属性后,您仍然遇到相同版本的库,请检查 Spring Boot 的 BOM 中属性名称是否已更改,如果是,请使用新的属性名称。 |

或者,如果 spring-boot-dependencies 或 spring-boot-starter-parent 被导入到依赖项管理(<dependencyManagement>)中,那么可以通过导入列出我们想要覆盖的依赖项的 BOM,或者通过显式列出具有我们想要使用的版本的依赖项来覆盖版本。

<dependencyManagement>

<dependencies>

<!--

Overriding Hibernate ORM version by importing the BOM.

Alternatively, can be done by adding specific dependencies

as shown below for Elasticsearch dependencies.

-->

<dependency>

<groupId>org.hibernate.orm</groupId>

<artifactId>hibernate-platform</artifactId>

<version>${version.org.hibernate.orm}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-dependencies</artifactId>

<version>3.3.0</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<!--

Since there is no BOM for the Elasticsearch REST client,

these dependencies have to be listed explicitly:

-->

<dependency>

<groupId>org.elasticsearch.client</groupId>

<artifactId>elasticsearch-rest-client</artifactId>

<version>8.15.0</version>

</dependency>

<dependency>

<groupId>org.elasticsearch.client</groupId>

<artifactId>elasticsearch-rest-client-sniffer</artifactId>

<version>8.15.0</version>

</dependency>

<!-- Other dependency management entries -->

</dependencies>

</dependencyManagement>对于其他构建工具,请参阅其文档以了解详细信息。

|

Maven 的 |

|

如果在设置了上面的属性后,您仍然遇到一些 Hibernate Search 依赖项的问题(例如 |

应用程序在启动时挂起

Spring Boot 2.3.x 及更高版本受一个 bug 的影响,该 bug 会导致应用程序在使用 Hibernate Search 时启动时挂起,尤其是在使用自定义组件(自定义桥接器、分析配置器等)时。

这个问题并不局限于 Hibernate Search,已报告,但在 Spring Boot 2.5.1 中尚未修复。

作为一种解决方法,您可以将属性spring.data.jpa.repositories.bootstrap-mode设置为deferred,如果这不起作用,则设置为default。有趣的是,使用@EnableJpaRepositories(bootstrapMode = BootstrapMode.DEFERRED)据报道即使在将spring.data.jpa.repositories.bootstrap-mode设置为deferred不起作用的情况下也能正常工作。

或者,如果您不需要在自定义组件中进行依赖注入,您可以使用前缀constructor:引用这些组件,这样 Hibernate Search 甚至不会尝试使用 Spring 来检索组件,从而避免 Spring 中的死锁。有关更多信息,请参阅此部分。

Spring Boot 的 Elasticsearch 客户端和自动配置

如您所知,Spring Boot 包含“自动配置”,它会在类路径中检测到依赖项后立即触发。

在某些情况下,当应用程序使用依赖项但不通过 Spring Boot 使用时,这可能会导致问题。

特别是,Hibernate Search 会传递性地引入对 Elasticsearch 的低级 REST 客户端的依赖。Spring Boot 通过ElasticsearchRestClientAutoConfiguration,将在检测到对 Elasticsearch REST 客户端 JAR 的依赖后,自动设置一个指向(默认情况下)https://:9200 的 Elasticsearch REST 客户端。

如果您的 Elasticsearch 集群无法在https://:9200访问,这可能会导致启动时出现错误。

要消除这些错误,请手动配置 Spring 的 Elasticsearch 客户端,或禁用此特定自动配置。

|

Spring Boot 的 Elasticsearch 客户端与 Hibernate Search 完全独立:一个的配置不会影响另一个。 |

2. Hibernate Search 入门

要开始使用 Hibernate Search,请查看以下指南

-

如果您的实体在 Hibernate ORM 中定义,请参阅在 Hibernate ORM 中使用 Hibernate Search 入门。

-

如果您的实体不在 Hibernate ORM 中定义,请参阅使用 Hibernate Search 的独立 POJO 映射器入门。

3. 迁移

如果您要将现有应用程序从早期版本的 Hibernate Search 升级到最新版本,请务必查看迁移指南。

|

对于 Hibernate Search 5 用户 如果您从 Maven 存储库中提取我们的工件,并且您来自 Hibernate Search 5,请注意,仅仅将版本号提升是不够的。 特别是,组 ID 从 此外,请注意,许多 API 已经改变,有些仅仅是因为包的改变,而另一些则是由于更根本的改变(例如,不再在 Hibernate Search API 中使用 Lucene 类型)。因此,建议您首先使用6.0 迁移指南迁移到 Hibernate Search 6.0,然后迁移到更高版本(这将容易得多)。 |

4. 概念

4.1. 全文搜索

全文搜索是一组用于在文本文档语料库中搜索最匹配给定查询的文档的技术。

与传统搜索(例如在 SQL 数据库中)的主要区别在于,存储的文本不被视为单个文本块,而是被视为标记(词语)的集合。

Hibernate Search 依赖于Apache Lucene或Elasticsearch来实现全文搜索。由于 Elasticsearch 在内部使用 Lucene,因此它们共享许多特征,并且它们对全文搜索的总体方法也类似。

为了简化,这些搜索引擎基于倒排索引的概念:一个字典,其中键是文档中找到的标记(词语),值是包含此标记的每个文档的标识符列表。

仍然简化,一旦所有文档都被索引,搜索文档将涉及三个步骤

-

从查询中提取标记(词语);

-

在索引中查找这些标记以查找匹配的文档;

-

聚合查找结果以生成匹配文档列表。

|

Lucene 和 Elasticsearch 不仅限于文本搜索:还支持数值数据,从而支持整数、双精度数、长整数、日期等。这些类型使用稍微不同的方法进行索引和查询,显然不涉及文本处理。 |

4.2. 实体类型

在应用程序的域模型方面,Hibernate Search 区分了被视为实体的类型(Java 类)和那些不被视为实体的类型。

Hibernate Search 中实体类型的决定性特征是它们的实例具有不同的生命周期:实体实例可以保存到数据存储中,也可以从数据存储中检索,而无需保存或检索其他类型的实例。为此,假设每个实体实例都带有不可变的唯一标识符。

这些特征允许 Hibernate Search 将实体类型映射到索引,但只能映射实体类型。“嵌入式”类型从实体中引用或包含在实体中,但其生命周期完全与实体相关联,不能映射到索引。

Hibernate Search 的多个方面涉及实体类型的概念

-

每个实体类型都有一个实体名称,它与类型名称不同。例如,对于名为

com.acme.Book的类,实体名称可以是Book(默认值)或任何任意选择的字符串。 -

指向实体类型的属性(称为关联)具有特定的机制;特别是,为了处理重新索引,Hibernate Search 需要了解关联的逆向。

-

为了在重新索引时进行更改跟踪(例如,在索引计划中),实体类型代表 Hibernate Search 考虑的最小范围。

这意味着代表“已更改属性”的路径始终以实体为起点,并且这些路径中的组件永远不会进入另一个实体(但可能指向一个实体,当关联更改时)。

-

Hibernate Search 可能需要额外的配置来启用从外部数据存储中加载实体类型,无论是从外部源加载匹配查询的实体,还是从外部源加载所有实体实例以进行完全重新索引。

4.3. 映射

Hibernate Search 的目标应用程序使用基于实体的模型来表示数据。在这个模型中,每个实体都是一个具有几个原子类型属性(String、Integer、LocalDate等)的单个对象。每个实体可以包含非根聚合(“嵌入式”类型),并且每个实体也可以与一个或多个其他实体建立多个关联。

相比之下,Lucene 和 Elasticsearch 使用文档。每个文档都是“字段”的集合,每个字段都被分配一个名称(一个唯一的字符串)和一个值(可以是文本,也可以是数值数据,例如整数或日期)。字段也具有类型,这不仅决定了值的类型(文本/数值),而且更重要的是决定了该值存储的方式:索引、存储、使用文档值等。每个文档可以包含嵌套的聚合(“对象”/“嵌套文档”),但实际上不能在顶层文档之间建立关联。

因此

-

实体被组织成一个图,其中每个节点都是一个实体,每个关联都是一条边。

-

文档被组织成一个树的集合(充其量),其中每棵树都是一个文档,可以选择包含嵌套文档。

实体模型和文档模型之间存在多个不匹配:简单属性类型与更复杂的字段类型,关联与无关联,图与树的集合。

在 Hibernate Search 中,映射的目标是通过定义如何将一个或多个实体转换为文档,以及如何将搜索命中解析回原始实体来解决这些不匹配。这是 Hibernate Search 的主要附加值,是其他所有内容的基础,从索引到各种搜索 DSL。

映射通常使用实体模型中的注释进行配置,但这也可以通过编程 API 实现。要详细了解如何配置映射,请参阅 将实体映射到索引。

要了解如何索引生成的文档,请参阅 索引实体(提示:对于Hibernate ORM 集成,它是自动的)。

要了解如何使用利用映射更接近实体模型的 API 进行搜索,特别是通过返回实体作为命中而不是仅返回文档标识符,请参阅 搜索。

4.4. 绑定

虽然映射定义是声明性的,但这些声明需要被解释并实际应用于域模型。

这就是 Hibernate Search 所谓的“绑定”:在启动时,给定的映射指令(例如 `@GenericField`)将导致一个“绑定器”实例化并被调用,使其有机会检查应用于域模型的那一部分,并“绑定”(分配)一个组件到该模型部分——例如一个“桥”,负责在索引过程中从实体中提取数据。

Hibernate Search 为许多常见用例提供了绑定器和桥梁,并且还提供了插入自定义绑定器和桥梁的功能。

有关更多信息,特别是关于如何插入自定义绑定器和桥梁,请参阅 绑定和桥梁。

4.5. 分析

如 全文搜索 中所述,全文引擎在词元上工作,这意味着文本必须在索引时(文档处理,用于构建词元 → 文档索引)和搜索时(查询处理,用于生成要查找的词元列表)进行处理。

但是,处理不仅仅是“词元化”。索引查找是**精确**查找,这意味着查找 `Great`(大写)不会返回仅包含 `great`(全小写)的文档。在处理文本时执行一个额外的步骤来解决此问题:词元过滤,它会规范词元。由于这种“规范化”,`Great` 将被索引为 `great`,因此对查询 `great` 进行索引查找将按预期匹配。

在 Lucene 世界(Lucene、Elasticsearch、Solr,…)中,在索引和搜索阶段期间对文本进行处理被称为“分析”,并且由“分析器”执行。

分析器由三种类型的组件组成,它们将依次按以下顺序处理文本

-

字符过滤器:转换输入字符。替换、添加或删除字符。

-

词元化器:将文本拆分为几个词,称为“词元”。

-

词元过滤器:转换词元。替换、添加或删除词元中的字符,从现有词元中派生新词元,根据某些条件删除词元,…

词元化器通常在空格处分割(尽管还有其他选项)。词元过滤器通常是自定义发生的地方。它们可以删除带重音符号的字符,删除无意义的后缀(`-ing`、`-s`,…)或词元(`a`、`the`,…),用选定的拼写替换词元(`wi-fi` ⇒ `wifi`)等。

|

字符过滤器虽然有用,但很少使用,因为它们不了解词元边界。 除非你知道你在做什么,否则你通常应该优先考虑词元过滤器。 |

在某些情况下,需要将文本以一个块的形式进行索引,而不进行任何词元化

-

对于某些类型的文本,例如 SKU 或其他业务代码,词元化根本没有意义:文本是一个单一的“关键字”。

-

对于按字段值排序,词元化是不必要的。在 Hibernate Search 中它也是被禁止的,因为性能问题;只有非词元化的字段才能排序。

为了解决这些用例,提供了一种特殊类型的分析器,称为“规范化器”。规范化器只是保证不使用词元化器的分析器:它们只能使用字符过滤器和词元过滤器。

在 Hibernate Search 中,分析器和规范化器通过其名称引用,例如 在定义全文字段时。分析器和规范化器具有两个单独的命名空间。

某些名称已经分配给内置分析器(特别是在 Elasticsearch 中),但可以(也建议)将名称分配给自定义分析器和规范化器,这些分析器和规范化器使用内置组件(词元化器、过滤器)组装起来以满足您的特定需求。

每个后端都公开其自己的 API 来定义分析器和规范化器,以及通常配置分析。有关更多信息,请参阅每个后端的文档

4.6. 提交和刷新

为了在索引和搜索时获得最佳吞吐量,Elasticsearch 和 Lucene 都依赖于在写入和读取索引时的“缓冲区”。

-

在写入时,更改不会直接写入索引,而是写入一个“索引写入器”,它在内存中或临时文件中缓冲更改。

当写入器提交时,更改会被“推送到”实际的索引。在提交发生之前,未提交的更改处于“不安全”状态:如果应用程序崩溃或服务器发生断电,未提交的更改将丢失。

-

在读取时,例如执行搜索查询时,数据不会直接从索引中读取,而是从“索引读取器”中读取,该读取器公开索引在过去某个时间点的视图。

当读取器刷新时,视图会被更新。在刷新发生之前,搜索查询的结果可能略微过时:自上次刷新后添加的文档将缺失,自上次刷新后删除的文档仍然存在,等等。

不安全的更改和不同步的索引显然是不可取的,但它们是提高性能的折衷方案。

不同的因素会影响刷新和提交的时间

-

监听器触发的索引 和 显式索引 默认情况下将要求在每组更改后执行索引写入器的提交,这意味着更改在 Hibernate ORM 事务提交返回后是安全的(对于 Hibernate ORM 集成)或 `SearchSession` 的 `close()` 方法返回后(对于 独立 POJO 映射器)。但是,默认情况下不会请求刷新,这意味着更改可能只在稍后,当后端决定刷新索引读取器时才可见。此行为可以通过设置不同的 同步策略 来自定义。

-

批量索引器 在批量索引结束之前不会要求任何提交或刷新,以最大限度地提高索引吞吐量。

-

无论何时没有特定的提交或刷新要求,都会应用后端默认设置

-

可以通过 `flush()` API 显式强制执行提交。

-

可以通过 `refresh()` API 显式强制执行刷新。

|

即使我们使用“提交”一词,但这与关系数据库事务中的提交概念不同:没有事务,并且无法“回滚”。 也没有隔离的概念。刷新后,所有对索引的更改都会被考虑在内:那些提交到索引的更改,以及那些仍然缓存在索引写入器中的更改。 因此,提交和刷新可以被视为完全正交的概念:某些设置偶尔会导致提交的更改在搜索查询中不可见,而其他设置则允许甚至未提交的更改在搜索查询中可见。 |

4.7. 分片和路由

分片是指将索引数据拆分为多个“更小的索引”,称为分片,以便在处理大量数据时提高性能。

在 Hibernate Search 中,与 Elasticsearch 类似,另一个与分片密切相关的概念是路由。路由是指将文档标识符或通常称为“路由键”的任何字符串解析到相应的分片。

在索引时

-

从被索引的实体生成一个文档标识符,以及可选的路由键。

-

文档及其标识符以及可选的路由键传递给后端。

-

后端将文档“路由”到正确的分片,并将路由键(如果有)添加到文档中的特殊字段(以便进行索引)。

-

文档在该分片中被索引。

在搜索时

-

搜索查询可以选择传递一个或多个路由键。

-

如果没有传递路由键,查询将在所有分片上执行。

-

如果传递了一个或多个路由键

-

后端将这些路由键解析为一组分片,并且查询只会在所有分片上执行,忽略其他分片。

-

一个过滤器被添加到查询中,以便只匹配使用给定路由键之一进行索引的文档。

-

因此,分片可以通过两种方式来提高性能

-

在索引时:分片索引可以将“压力”分散到多个分片,这些分片可以位于不同的磁盘(Lucene)或不同的服务器(Elasticsearch)上。

-

在搜索时:如果一个属性,我们称之为 `category`,经常被用来选择一个文档子集,这个属性可以 在映射中定义为路由键,以便它被用来路由文档而不是文档 ID。因此,具有相同 `category` 值的文档将被索引到同一个分片中。然后在搜索时,如果一个查询已经过滤了文档,以便已知命中将具有相同的 `category` 值,则该查询可以手动 路由到包含具有此值的文档的分片,并且可以忽略其他分片。

要启用分片,需要一些配置

|

分片本质上是静态的:预期每个索引都具有相同的分片,以及相同的标识符,从一个启动到另一个启动。更改分片的数量或它们的标识符将需要完全重新索引。 |

5. 架构

5.1. Hibernate Search 的组件

从用户的角度来看,Hibernate Search 包含两个组件

- 映射器

-

映射器将用户模型“映射”到索引模型,并提供与用户模型一致的 API 来执行索引和搜索。

大多数应用程序依赖于 Hibernate ORM 映射器,它提供了索引 Hibernate ORM 实体属性的功能,但还有一个 独立 POJO 映射器,可以在没有 Hibernate ORM 的情况下使用。

映射器部分通过域模型上的注释进行配置,部分通过配置属性进行配置。

- 后端

-

后端是全文引擎的抽象,在这里“事情得到完成”。它实现通用的索引和搜索接口,供映射器通过“索引管理器”使用,每个索引管理器提供对一个索引的访问。

例如,Lucene 后端 委托给 Lucene 库,而 Elasticsearch 后端 委托给远程 Elasticsearch 集群。

后端配置部分由映射器完成,它告诉后端哪些索引必须存在以及它们必须包含哪些字段,部分通过配置属性完成。

映射器和后端协同工作以提供三个主要功能

- 批量索引

-

这是 Hibernate Search 根据数据库内容从零开始重建索引的方式。

映射器查询数据库以检索每个实体的标识符,然后分批处理这些标识符,加载实体,然后处理它们以生成发送到后端进行索引的文档。后端将文档放入内部队列,并将分批在后台进程中索引文档,并在完成时通知映射器。

有关详细信息,请参阅 使用

MassIndexer索引大量数据。 - 显式和侦听器触发的索引

-

显式和侦听器触发的索引依赖于索引计划(

SearchIndexingPlan)以索引特定实体,因为它们受到有限更改的影响。使用 显式索引,调用者显式地将有关实体更改的信息传递给 索引计划;使用 侦听器触发的索引,实体更改由 Hibernate ORM 集成(存在一些例外)透明地检测到,并自动添加到索引计划中。

侦听器触发的索引仅在 Hibernate ORM 集成 的上下文中才有意义;独立 POJO 映射器中没有此功能。 在这两种情况下,索引计划 都将根据这些更改推断出是否需要重新索引实体,无论是更改的实体本身还是 索引中嵌入更改实体的其他实体。

在事务提交时,索引计划中的更改将被处理(在同一线程中或在后台进程中,具体取决于 协调策略),并生成文档,然后发送到后端进行索引。后端将文档放入内部队列,并将分批在后台进程中索引文档,并在完成时通知映射器。

有关详细信息,请参阅 隐式,侦听器触发的索引。

- 搜索

-

这是 Hibernate Search 提供查询索引的方法。

映射器公开对搜索 DSL 的入口点,允许选择要查询的实体类型。选择一个或多个实体类型后,映射器将委托给相应的索引管理器以提供搜索 DSL 并最终创建搜索查询。在查询执行时,后端向映射器提交一个实体引用的列表,映射器加载相应的实体。然后,查询返回这些实体。

有关详细信息,请参阅 搜索。

5.2. 架构示例

5.2.1. 概述

| 架构 | 带有 Lucene 的单节点 | 与 Elasticsearch 无协调 | 带有 Elasticsearch 的出站箱轮询 |

|---|---|---|---|

兼容 映射器 |

同时支持 Hibernate ORM 集成 和 独立 POJO 映射器 |

仅支持 Hibernate ORM 集成 |

|

应用程序拓扑 |

单节点 |

单节点或多节点 |

|

需要维护的额外内容 |

文件系统上的索引 |

Elasticsearch 集群 |

|

索引更新保证 |

|||

索引更新可见性 |

|||

原生功能 |

主要面向专家 |

面向所有人 |

|

应用程序线程开销 |

|||

数据库开销 |

|||

对数据库模式的影响 |

无 |

||

侦听器触发的索引忽略:JPQL/SQL 查询,非对称关联更新 |

|||

在极少数情况下,索引可能不同步:并发 |

没有其他已知局限性 |

||

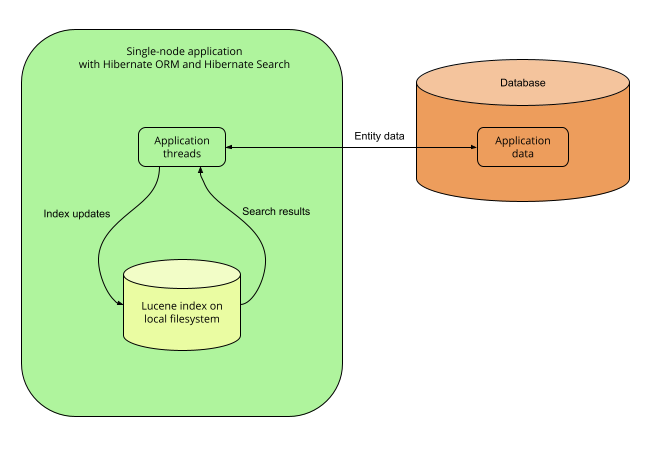

5.2.2. 带有 Lucene 后端的单节点应用程序

优缺点

优点

-

简单:不需要外部服务,所有内容都位于同一台服务器上。

-

索引更新的即时可见性(〜毫秒)。虽然其他架构在大多数用例中也能表现出类似的性能,但对于需要在数据库更改后立即可见更改的索引,单节点 Lucene 后端是最佳选择。

缺点

-

不太容易扩展:经验丰富的开发人员可以访问很多 Lucene 功能,即使是 Hibernate Search 未公开的那些功能,也可以通过提供原生 Lucene 对象来访问;但是,对于不熟悉 Lucene 的开发人员来说,Lucene API 并不容易理解。如果你感兴趣,请参阅 基于

Query的谓词。 -

应用程序线程开销:重新索引直接在应用程序线程中完成,并且可能需要额外的时间从数据库中加载必须索引的数据。根据要加载的数据量,这可能会增加应用程序的延迟和/或降低其吞吐量。

-

没有横向可扩展性:只能有一个应用程序节点,所有索引都必须位于同一台服务器上。

入门

要实现此架构,请使用以下 Maven 依赖项

<dependency>

<groupId>org.hibernate.search</groupId>

<artifactId>hibernate-search-mapper-orm</artifactId>

<version>7.2.0.Final</version>

</dependency>

<dependency>

<groupId>org.hibernate.search</groupId>

<artifactId>hibernate-search-backend-lucene</artifactId>

<version>7.2.0.Final</version>

</dependency>- 使用 独立 POJO 映射器(没有 Hibernate ORM)

<dependency>

<groupId>org.hibernate.search</groupId>

<artifactId>hibernate-search-mapper-pojo-standalone</artifactId>

<version>7.2.0.Final</version>

</dependency>

<dependency>

<groupId>org.hibernate.search</groupId>

<artifactId>hibernate-search-backend-lucene</artifactId>

<version>7.2.0.Final</version>

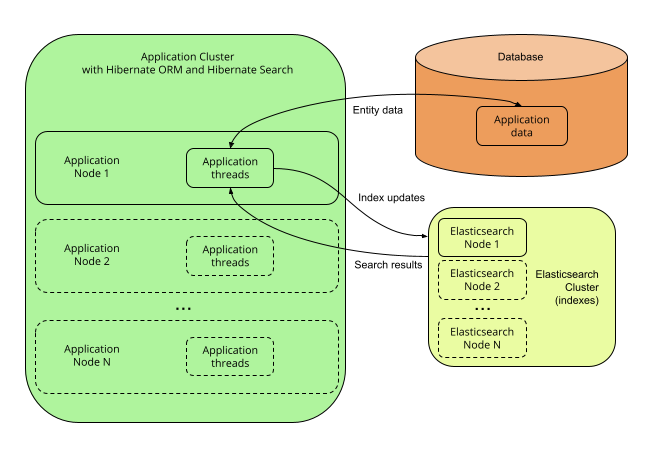

</dependency>5.2.3. 单节点或多节点应用程序,没有协调,并使用 Elasticsearch 后端

描述

使用 Elasticsearch 后端,索引不会绑定到应用程序节点。它们由一个单独的 Elasticsearch 节点集群管理,并通过对 REST API 的调用来访问。

因此,可以设置多个应用程序节点,以便它们以一种方式独立地执行索引更新和搜索查询,而无需相互协调。

| Elasticsearch 集群可以是一个单节点,它与应用程序位于同一台服务器上。 |

优缺点

优点

-

易于扩展:您可以轻松地访问大多数 Elasticsearch 功能,即使是 Hibernate Search 未公开的那些功能,也可以通过提供自己的 JSON 来访问。例如,请参阅 JSON 定义的谓词,或 JSON 定义的聚合,或 利用 JSON 操作高级功能。

-

索引的横向可扩展性:您可以根据需要调整 Elasticsearch 集群的大小。请参阅 "Elasticsearch 文档中的可扩展性和弹性"。

-

应用程序的横向可扩展性:您可以根据需要拥有任意多个应用程序实例(尽管高并发会增加此架构出现某些问题的可能性,请参阅下面的“缺点”)。

缺点

-

需要管理一项额外的服务:Elasticsearch 集群。

-

应用程序线程开销:重新索引直接在应用程序线程中完成,并且可能需要额外的时间从数据库中加载必须索引的数据。根据要加载的数据量,这可能会增加应用程序的延迟和/或降低其吞吐量。

-

索引更新的延迟可见性(〜1 秒)。虽然可以在数据库更改后尽快使更改可见,但 Elasticsearch 本质上是 近实时,如果你需要在数据库更改后立即可见更改,那么它的性能不会很好。

入门

要实现此架构,请使用以下 Maven 依赖项

<dependency>

<groupId>org.hibernate.search</groupId>

<artifactId>hibernate-search-mapper-orm</artifactId>

<version>7.2.0.Final</version>

</dependency>

<dependency>

<groupId>org.hibernate.search</groupId>

<artifactId>hibernate-search-backend-elasticsearch</artifactId>

<version>7.2.0.Final</version>

</dependency>- 使用 独立 POJO 映射器(没有 Hibernate ORM)

<dependency>

<groupId>org.hibernate.search</groupId>

<artifactId>hibernate-search-mapper-pojo-standalone</artifactId>

<version>7.2.0.Final</version>

</dependency>

<dependency>

<groupId>org.hibernate.search</groupId>

<artifactId>hibernate-search-backend-elasticsearch</artifactId>

<version>7.2.0.Final</version>

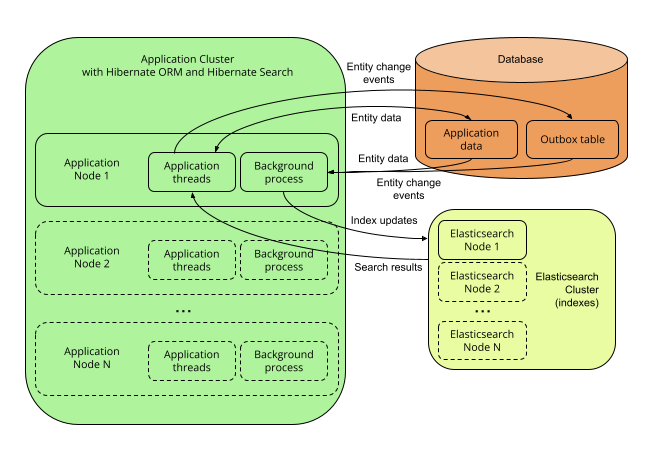

</dependency>5.2.4. 带有出站箱轮询和 Elasticsearch 后端的多节点应用程序

|

以下详细介绍的功能处于 孵化 状态:它们仍在积极开发中。 通常的 兼容性策略 不适用:孵化元素(例如类型、方法、配置属性等)的契约可能会在后续版本中以向后不兼容的方式更改(甚至被删除)。 建议您使用孵化功能,以便开发团队可以获得反馈并改进它们,但您应该准备好根据需要更新依赖于它们的代码。 |

描述

使用 Hibernate Search 的 outbox-polling 协调策略,实体更改事件不会在产生它们的 ORM 会话中立即处理,而是被推送到数据库中的出站箱表中。

一个后台进程轮询该出站箱表以获取新事件,并异步处理它们,根据需要更新索引。由于该队列 可以进行分片,因此多个应用程序节点可以共享索引的工作负载。

这需要 Elasticsearch 后端,以便索引不会绑定到单个应用程序节点,并且可以从多个应用程序节点进行更新或查询。

优缺点

优点

-

最安全

-

这里消除了其他架构中由于 后端中的索引错误 而导致索引不同步的可能性,因为实体更改事件 在与实体更改相同的事务中持久化,允许无限次重试。

-

这里消除了其他架构中由于 并发更新 而导致索引不同步的可能性,因为 在重新索引之前,每个实体实例都在一个新事务中从数据库中重新加载。

-

-

易于扩展:您可以轻松地访问大多数 Elasticsearch 功能,即使是 Hibernate Search 未公开的那些功能,也可以通过提供自己的 JSON 来访问。例如,请参阅 JSON 定义的谓词,或 JSON 定义的聚合,或 利用 JSON 操作高级功能。

-

应用程序线程开销最小:应用程序线程 只需要将事件追加到队列中,它们本身不执行重新索引。

-

索引的横向可扩展性:您可以根据需要调整 Elasticsearch 集群的大小。请参阅 "Elasticsearch 文档中的可扩展性和弹性"。

-

应用程序的横向可扩展性:您可以根据需要拥有任意多个应用程序实例。

缺点

-

需要管理一项额外的服务:Elasticsearch 集群。

-

索引更新的延迟可见性(〜1 秒或更长,具体取决于负载和硬件)。首先是因为 Elasticsearch 本质上是 近实时,但也是因为 事件队列引入了额外的延迟。

-

对数据库模式的影响:必须在数据库中创建额外的表格 以保存协调所需的数据。

-

数据库开销:读取实体更改并执行重新索引的后台进程 需要从数据库中读取已更改的实体。

入门

outbox-polling 协调策略需要额外的依赖项。要实现此架构,请使用以下 Maven 依赖项

<dependency>

<groupId>org.hibernate.search</groupId>

<artifactId>hibernate-search-mapper-orm</artifactId>

<version>7.2.0.Final</version>

</dependency>

<dependency>

<groupId>org.hibernate.search</groupId>

<artifactId>hibernate-search-mapper-orm-outbox-polling</artifactId>

<version>7.2.0.Final</version>

</dependency>

<dependency>

<groupId>org.hibernate.search</groupId>

<artifactId>hibernate-search-backend-elasticsearch</artifactId>

<version>7.2.0.Final</version>

</dependency>- 使用 独立 POJO 映射器(没有 Hibernate ORM)

-

目前,无法使用独立 POJO 映射器实现此架构,因为此映射器 不支持协调。

此外,请按照outbox-polling: 后台处理器中的附加事件表和轮询中所述配置协调。

6. Hibernate ORM 集成

6.2. 启动

Hibernate Search 集成到 Hibernate ORM 中,将在 Hibernate ORM 同时启动,只要它存在于类路径中。

如果由于某种原因需要阻止 Hibernate Search 启动,请将 布尔属性 hibernate.search.enabled 设置为 false。

6.3. 关闭

Hibernate Search 集成到 Hibernate ORM 中,将在 Hibernate ORM 同时停止。

在关闭时,Hibernate Search 将停止接受新的索引请求:新的索引尝试将抛出异常。Hibernate ORM 关闭将阻塞,直到所有正在进行的索引操作完成。

6.4. 映射 Map 驱动的模型

"动态映射" 实体模型,即基于 java.util.Map 而不是自定义类的模型,无法使用注释进行映射。但是,它们可以使用 编程映射 API 进行映射。您只需使用 context.programmaticMapping().type("thename") 按名称引用类型即可

-

传递动态实体类型的实体名称。

-

传递动态嵌入/组件类型的“角色”,即拥有实体的名称,后跟一个点("."),后跟该实体中组件的点分隔路径。例如

MyEntity.myEmbedded或MyEntity.myEmbedded.myNestedEmbedded。

6.5. 使用非字符串租户标识符的多租户

虽然使用 Hibernate ORM 中的字符串租户标识符在 Hibernate Search 中具有内置支持,但使用非字符串租户标识符需要配置自定义租户标识符转换器。这可以通过将 TenantIdentifierConverter 类型的 bean 引用传递给 hibernate.search.multi_tenancy.tenant_identifier_converter 配置属性来完成。

6.6. 其他配置

其他配置属性在本文档的相关部分中提到。您可以在 ORM 集成配置属性附录 中找到可用属性的完整参考。

7. 独立 POJO 映射器

|

以下详细介绍的功能处于 孵化 状态:它们仍在积极开发中。 通常的 兼容性策略 不适用:孵化元素(例如类型、方法、配置属性等)的契约可能会在后续版本中以向后不兼容的方式更改(甚至被删除)。 建议您使用孵化功能,以便开发团队可以获得反馈并改进它们,但您应该准备好根据需要更新依赖于它们的代码。 |

7.1. 基础

独立 POJO 映射器 使得能够将任意 POJO 映射到索引。

与 Hibernate ORM 集成 相比,其主要功能是可以不使用 Hibernate ORM 或关系数据库运行。

它可用于索引来自任意数据存储的实体,甚至(尽管这通常不推荐)使用 Lucene 或 Elasticsearch 作为主要数据存储。

因为独立 POJO 映射器除了实体以 POJO 的形式表示之外,对要映射的实体没有假设任何东西,因此它可能比 Hibernate ORM 集成 更复杂。特别地

-

此映射器 无法自行检测实体更改:所有索引 必须是显式的。

-

此映射器 目前不提供节点之间的协调。

7.2. 启动

使用独立 POJO 映射器启动 Hibernate Search 是显式的,并涉及一个构建器

CloseableSearchMapping searchMapping =

SearchMapping.builder( AnnotatedTypeSource.fromClasses( (1)

Book.class, Associate.class, Manager.class

) )

.property(

"hibernate.search.backend.hosts", (2)

"elasticsearch.mycompany.com"

)

.build(); (3)

| 1 | 创建一个构建器,传递一个 AnnotatedTypeSource,让 Hibernate Search 知道在哪里查找注释。 |

| 2 | 设置其他配置属性(另请参见 配置)。 |

| 3 | 构建 SearchMapping。 |

7.3. 关闭

您可以通过在映射上调用 close() 方法来关闭使用独立 POJO 映射器的 Hibernate Search

CloseableSearchMapping searchMapping = /* ... */ (1)

searchMapping.close(); (2)| 1 | 检索 Hibernate Search 启动时 返回的 SearchMapping。 |

| 2 | 调用 close() 以关闭 Hibernate Search。 |

在关闭时,Hibernate Search 将停止接受新的索引请求:新的索引尝试将抛出异常。close() 方法仅在所有正在进行的索引操作完成后才会返回。

7.4. Bean 提供程序

|

以下详细介绍的功能处于 孵化 状态:它们仍在积极开发中。 通常的 兼容性策略 不适用:孵化元素(例如类型、方法、配置属性等)的契约可能会在后续版本中以向后不兼容的方式更改(甚至被删除)。 建议您使用孵化功能,以便开发团队可以获得反馈并改进它们,但您应该准备好根据需要更新依赖于它们的代码。 |

独立 POJO 映射器可以 从 CDI/Spring 中检索 bean,但这种支持需要通过 bean 提供程序显式实现。

您可以在两个步骤中插入自己的 bean 提供程序

-

定义一个实现

org.hibernate.search.engine.environment.bean.spi.BeanProvider接口的类。 -

通过将配置属性

hibernate.search.bean_provider设置为指向实现的 bean 引用(例如class:com.mycompany.MyMappingConfigurer)来配置 Hibernate Search 以使用该实现。显然,bean 提供程序的引用无法使用 bean 提供程序解析。

7.5. 多租户

在启动独立 POJO 映射器时,需要显式启用多租户

CloseableSearchMapping searchMapping = SearchMapping.builder( AnnotatedTypeSource.fromClasses( (1)

Book.class

) )

// ...

.property( "hibernate.search.mapping.multi_tenancy.enabled", true ) (2)

.build(); (3)| 1 | 创建一个构建器。 |

| 2 | 启用多租户。 |

| 3 | 构建 SearchMapping。 |

SearchSessionSearchMapping searchMapping = /* ... */ (1)

Object tenantId = "myTenantId";

try ( SearchSession searchSession = searchMapping.createSessionWithOptions() (2)

.tenantId( tenantId ) (3)

.build() ) { (4)

// ...

}| 1 | 检索 SearchMapping. |

| 2 | 开始创建一个新会话。 |

| 3 | 为新会话设置租户标识符。 |

| 4 | 构建新会话。 |

|

使用非字符串租户标识符时,必须提供自定义

|

7.6. 映射

虽然 Hibernate ORM 集成 可以从 Hibernate ORM 映射推断出映射的一部分,但独立 POJO 映射器不能。因此,独立 POJO 映射器需要对其映射进行更显式的配置

7.7. 索引

7.7.2. 在实体更改事件上显式索引

独立 POJO 映射器可以处理实体更改事件(添加、更新、删除)并相应地执行索引,尽管必须将事件显式传递给 Hibernate Search。有关 API 的更多信息,请参见 索引计划。

与 Hibernate ORM 集成 的一个主要区别是,事务(JTA 或其他)不受支持,因此索引是在 会话关闭 时执行的,而不是在事务提交时执行的。

7.7.3. 批量索引

因为默认情况下,独立 POJO 映射器对实体数据来自哪里一无所知,因此 批量索引 需要插入一种从其他数据存储中加载实体的方式:批量加载策略。

7.7.4. 搜索查询中的实体加载

因为默认情况下,独立 POJO 映射器对实体数据来自哪里一无所知,因此 搜索查询中的实体加载 需要插入一种从其他数据存储中加载实体选择的方式:选择加载策略。

|

使用独立 POJO 映射器,如果您希望从索引加载实体,而不是从外部数据源加载实体,请在您的实体类型中添加一个 投影构造函数。 当此部分描述的配置缺失并且需要加载时(例如,当不在搜索查询中使用 |

7.8. 协调

独立 POJO 映射器目前不提供任何在节点之间进行协调的方法,因此其行为大致类似于 无协调 中描述的行为,除了实体数据提取是在会话关闭时发生的,而不是在 Hibernate ORM 会话刷新时发生的,并且索引是在此之后立即发生的,而不是在事务提交时发生的。

7.9. 从文件读取配置属性

独立 POJO 映射器 SearchMappingBuilder 还可以从与 java.util.Properties#load(Reader) 兼容的 Reader 中获取属性

Reader 从文件加载配置属性try (

Reader propertyFileReader = /* ... */ (1)

) {

CloseableSearchMapping searchMapping = SearchMapping.builder( AnnotatedTypeSource.empty() ) (2)

.properties( propertyFileReader ) (3)

.build();

}| 1 | 获取表示包含配置属性的属性文件的读取器。 |

| 2 | 开始配置独立 POJO 映射器。 |

| 3 | 将属性文件读取器传递给构建器。 |

7.10. 其他配置

其他配置属性在本文档的相关部分中提到。您可以在 独立 POJO 映射器配置属性附录 中找到可用属性的完整参考。

8. 配置

8.1. 配置来源

8.1.1. 集成到 Hibernate ORM 中时的配置来源

当在 Hibernate ORM 中使用 Hibernate Search 时,配置属性将从 Hibernate ORM 中获取。

这意味着无论您在何处设置 Hibernate ORM 属性,您都可以设置 Hibernate Search 属性。

-

在您类路径根目录下的

hibernate.properties文件中。 -

在

persistence.xml中,如果您使用 JPA API 启动 Hibernate ORM。 -

在 JVM 系统属性中(传递给

java命令的-DmyProperty=myValue)。 -

在您的框架的配置文件中,例如

application.yaml/application.properties。

|

当通过您的框架的配置文件设置属性时,配置属性的键可能与本文档中提到的键不同。 例如, 有关更多信息,请参见 框架支持。 |

8.1.2. 使用独立 POJO 映射器的配置源

当在 独立 POJO 映射器(不使用 Hibernate ORM)中使用 Hibernate Search 时,必须在构建映射时以编程方式设置配置属性。

有关更多信息,请参见 本节。

8.2. 配置属性

8.2.1. 配置属性的结构

配置属性都分组在一个公共根目录下。在 ORM 集成中,此根目录为 hibernate.search,但其他集成(Infinispan 等)可能使用不同的根目录。本文档将在所有示例中使用 hibernate.search。

在该根目录下,我们可以区分三类属性。

- 全局属性

-

这些属性可能会影响所有 Hibernate Search。它们通常位于

hibernate.search根目录的正下方。全局属性在本文档的相关部分中解释。

-

以及更多。

- 后端属性

-

这些属性会影响单个后端。它们分组在一个公共根目录下

-

hibernate.search.backend用于默认后端(最常见的用法)。 -

hibernate.search.backends.<backend-name>用于命名后端(高级用法)。

后端属性在本文档的相关部分中解释。

-

- 索引属性

-

这些属性会影响一个或多个索引,具体取决于根目录。

使用根目录

hibernate.search.backend,它们为后端的所有索引设置默认值。使用根目录

hibernate.search.backend.indexes.<index-name>,它们为特定索引设置值,覆盖默认值(如果有)。后端和索引名称必须与映射中定义的名称匹配。对于 Hibernate ORM 实体,默认索引名称是索引类的名称,不包括包:org.mycompany.Book的默认索引名称为Book。索引名称可以在映射中自定义。或者,也可以通过名称引用后端,即上面的根目录也可以是

hibernate.search.backends.<backend-name>或hibernate.search.backends.<backend-name>.indexes.<index-name>。示例

-

hibernate.search.backend.io.commit_interval = 500为默认后端的所有索引设置io.commit_interval属性。 -

hibernate.search.backend.indexes.Product.io.commit_interval = 2000为默认后端的Product索引设置io.commit_interval属性。 -

hibernate.search.backends.myBackend.io.commit_interval = 500为后端myBackend的所有索引设置io.commit_interval属性。 -

hibernate.search.backends.myBackend.indexes.Product.io.commit_interval = 2000为后端myBackend的Product索引设置io.commit_interval属性。

其他索引属性在本文档的相关部分中解释。

-

8.2.2. 以编程方式构建属性键

BackendSettings 和 IndexSettings 都提供工具来帮助构建配置属性键。

- BackendSettings

-

BackendSettings.backendKey(ElasticsearchBackendSettings.HOSTS)等效于hibernate.search.backend.hosts。BackendSettings.backendKey("myBackend", ElasticsearchBackendSettings.HOSTS)等效于hibernate.search.backends.myBackend.hosts。有关可用属性键的列表,请参见 Elasticsearch 后端配置属性附录 或 Lucene 后端配置属性附录。

- IndexSettings

-

IndexSettings.indexKey("myIndex", ElasticsearchIndexSettings.INDEXING_QUEUE_SIZE)等效于hibernate.search.backend.indexes.myIndex.indexing.queue_size。IndexSettings.indexKey("myBackend", "myIndex", ElasticsearchIndexSettings.INDEXING_QUEUE_SIZE)等效于hibernate.search.backends.myBackend.indexes.myIndex.indexing.queue_size。有关可用属性键的列表,请参见 Elasticsearch 后端配置属性附录 或 Lucene 后端配置属性附录。查找以

hibernate.search.backend.indexes开头的变体属性。

private Properties buildHibernateConfiguration() {

Properties config = new Properties();

// backend configuration

config.put( BackendSettings.backendKey( ElasticsearchBackendSettings.HOSTS ), "127.0.0.1:9200" );

config.put( BackendSettings.backendKey( ElasticsearchBackendSettings.PROTOCOL ), "http" );

// index configuration

config.put(

IndexSettings.indexKey( "myIndex", ElasticsearchIndexSettings.INDEXING_MAX_BULK_SIZE ),

20

);

// orm configuration

config.put(

HibernateOrmMapperSettings.INDEXING_PLAN_SYNCHRONIZATION_STRATEGY,

IndexingPlanSynchronizationStrategyNames.ASYNC

);

// engine configuration

config.put( EngineSettings.BACKGROUND_FAILURE_HANDLER, "myFailureHandler" );

return config;

}8.2.3. 配置属性的类型

属性值可以以编程方式设置为 Java 对象,或者通过配置文件设置为必须解析的字符串。

Hibernate Search 中的每个配置属性都分配了一个类型,此类型定义了两种情况下都接受的值。

以下是对所有属性类型的定义。

| 名称 | 接受的 Java 对象 | 接受的字符串格式 |

|---|---|---|

字符串 |

|

任何字符串 |

布尔值 |

|

|

整数 |

|

任何可以由 |

长整数 |

|

任何可以由 |

类型为 T 的 Bean 引用 |

|

参见 Bean 引用的解析 |

当上面任何类型的配置属性被记录为多值时,该属性接受以下任一项:

-

包含任何 Java 对象的

java.util.Collection,这些 Java 对象将被接受为相同类型(参见上文)的单值属性; -

或包含字符串的逗号分隔字符串,这些字符串将被接受为相同类型(参见上文)的单值属性;

-

或接受为相同类型(参见上文)的单值属性的单个 Java 对象。

8.3. 配置属性检查

Hibernate Search 将跟踪实际使用的提供配置的部分,如果任何以“hibernate.search.”开头的配置属性从未使用过,则会记录警告,因为这可能表明配置存在问题。

要禁用此警告,请将 hibernate.search.configuration_property_checking.strategy 属性设置为 ignore。

8.4. Bean

Hibernate Search 允许在各种地方插入对自定义 Bean 的引用:配置属性、映射注释、API 参数等。

本节描述了 支持的框架、如何引用 Bean、如何解析 Bean 以及 如何将其他 Bean 注入 Bean。

8.4.1. 支持的框架

集成到 Hibernate ORM 时支持的框架

当使用 Hibernate Search 集成到 Hibernate ORM 时,所有集成到 Hibernate ORM 的依赖项注入框架都会自动集成到 Hibernate Search 中。

这包括但不限于

当不使用依赖项注入框架,或者当它未集成到 Hibernate ORM 时,只能通过反射来检索 Bean,方法是调用引用的类型的公共无参数构造函数;参见 Bean 解析。

使用独立 POJO 映射器时支持的框架

当使用 独立 POJO 映射器 时,必须 手动插入 依赖项注入支持。

否则,只能通过反射来检索 Bean,方法是调用引用的类型的公共无参数构造函数;参见 Bean 解析。

8.4.2. Bean 引用

Bean 引用由两部分组成

-

类型,即

java.lang.Class。 -

可选的名称,作为

String。

当在配置属性中使用字符串值引用 Bean 时,类型会隐式设置为 Hibernate Search 为该配置属性期望的任何接口。

|

对于有经验的用户,Hibernate Search 还提供了 |

8.4.3. Bean 引用的解析

当在配置属性中使用字符串值引用 Bean 时,将解析该字符串。

以下是最常见的格式

-

bean:后跟 Spring 或 CDI Bean 的名称。例如bean:myBean。 -

class:后跟类的完全限定名称,如果可用,则通过 Spring/CDI 实例化,否则通过其公共无参数构造函数实例化。例如class:com.mycompany.MyClass。 -

不包含冒号的任意字符串:它将按 Bean 解析 中的解释进行解释。简而言之

-

首先,查找具有给定名称的内置 Bean;

-

然后尝试从 Spring/CDI(如果可用)中检索具有给定名称的 Bean;

-

然后尝试将字符串解释为完全限定的类名,并从 Spring/CDI(如果可用)中检索相应的 Bean;

-

然后尝试将字符串解释为完全限定的类名,并通过其公共无参数构造函数实例化它。

-

以下格式也被接受,但仅适用于高级用例

-

any:后跟任意字符串。在大多数情况下,等效于省略前缀。仅当任意字符串包含冒号时才有用。 -

builtin:后跟内置 Bean 的名称,例如,Elasticsearch 索引布局策略 的simple。这不会回退到 Spring/CDI 或直接构造函数调用。 -

constructor:后跟类的完全限定名称,通过其公共无参数构造函数实例化。这将忽略内置 Bean,并且不会尝试通过 Spring/CDI 实例化类。

8.4.4. Bean 解析

Bean 解析(即,将此引用转换为对象实例的过程)默认情况下按如下方式进行

-

如果给定的引用与内置 Bean 匹配,则使用该 Bean。

示例:当使用

simple作为属性hibernate.search.backend.layout.strategy的值来配置 Elasticsearch 索引布局策略 时,simple会解析为内置的simple策略。 -

否则,如果 支持的依赖项注入 (DI) 框架 可用,则使用 DI 框架解析引用。

-

如果存在具有给定类型(以及如果提供,名称)的托管 Bean,则使用该 Bean。

示例:名称

myLayoutStrategy用作属性hibernate.search.backend.layout.strategy的值,用于配置Elasticsearch 索引布局策略,解析为 CDI/Spring 中已知的任何类型为IndexLayoutStrategy且带有@Named("myLayoutStrategy")注解的 Bean。 -

否则,如果给定名称且该名称是完全限定类名,并且存在该类型的托管 Bean,则使用该 Bean。

示例:名称

com.mycompany.MyLayoutStrategy用作属性hibernate.search.backend.layout.strategy的值,用于配置Elasticsearch 索引布局策略,解析为 CDI/Spring 中已知的任何扩展com.mycompany.MyLayoutStrategy的 Bean。

-

-

否则,将使用反射来解析 Bean。

-

如果给定名称且该名称是完全限定类名,并且该类扩展了类型引用,则通过调用该类的公共无参数构造函数来创建实例。

示例:名称

com.mycompany.MyLayoutStrategy用作属性hibernate.search.backend.layout.strategy的值,用于配置Elasticsearch 索引布局策略,解析为com.mycompany.MyLayoutStrategy的实例。 -

如果没有给出名称,则通过调用引用类型的公共无参数构造函数来创建实例。

示例:类

com.mycompany.MyLayoutStrategy.class(一个java.lang.Class,而不是String),用作属性hibernate.search.backend.layout.strategy的值,用于配置Elasticsearch 索引布局策略,解析为com.mycompany.MyLayoutStrategy的实例。

-

|

可以通过选择 |

8.4.5. Bean 注入

所有由 Hibernate Search 解析的 Bean 使用支持的框架可以利用此框架的注入功能。

例如,一个 Bean 可以通过在桥的某个字段上使用@Inject注解来注入另一个 Bean。

诸如@PostConstruct之类的生命周期注解也应该按预期工作。

即使不使用任何框架,仍然可以利用BeanResolver。此组件在引导过程中传递到多个方法,它公开多个方法来解析引用到 Bean,以编程方式公开通常通过@Inject注解实现的功能。有关更多信息,请参阅BeanResolver的 javadoc。

8.4.6. Bean 生命周期

一旦 Bean 不再需要,Hibernate Search 将释放它们,并让依赖注入框架调用适当的方法(@PreDestroy,…)。

某些 Bean 只在引导期间需要,例如ElasticsearchAnalysisConfigurer,因此它们将在引导后立即被释放。

其他 Bean 在运行时需要,例如ValueBridge,因此它们将在关闭时被释放。

|

小心地根据需要定义 Bean 的范围。 不可变 Bean 或只使用一次的 Bean,例如 但是,某些 Bean 预计是可变的,并且会实例化多次,例如 |

所有由 Hibernate Search 解析的 Bean 使用支持的框架可以利用此框架的注入功能。

8.5. 全局配置

8.5.1. 背景故障处理

Hibernate Search 通常将发生在后台线程中的异常传播到用户线程,但在某些情况下,例如 Lucene 段合并失败或某些索引计划同步失败,后台线程中的异常无法传播。默认情况下,当发生这种情况时,失败将记录在ERROR级别。

要自定义背景故障处理,您需要

-

定义一个实现

org.hibernate.search.engine.reporting.FailureHandler接口的类。 -

通过将配置属性

hibernate.search.background_failure_handler设置为指向实现的Bean 引用,例如class:com.mycompany.MyFailureHandler,来配置后端以使用该实现。

Hibernate Search 将在每次发生故障时调用handle方法。

FailureHandlerpackage org.hibernate.search.documentation.reporting.failurehandler;

import org.hibernate.search.engine.common.EntityReference;

import org.hibernate.search.engine.reporting.EntityIndexingFailureContext;

import org.hibernate.search.engine.reporting.FailureContext;

import org.hibernate.search.engine.reporting.FailureHandler;

import org.hibernate.search.util.impl.test.extension.StaticCounters;

public class MyFailureHandler implements FailureHandler {

@Override

public void handle(FailureContext context) { (1)

String failingOperationDescription = context.failingOperation().toString(); (2)

Throwable throwable = context.throwable(); (3)

// ... report the failure ... (4)

}

@Override

public void handle(EntityIndexingFailureContext context) { (5)

String failingOperationDescription = context.failingOperation().toString();

Throwable throwable = context.throwable();

for ( EntityReference entityReference : context.failingEntityReferences() ) { (6)

Class<?> entityType = entityReference.type(); (7)

String entityName = entityReference.name(); (7)

Object entityId = entityReference.id(); (7)

String entityReferenceAsString = entityReference.toString(); (8)

// ... process the entity reference ... (9)

}

}

}| 1 | handle(FailureContext)用于不符合任何其他专用handle方法的通用故障。 |

| 2 | 从上下文中获取失败操作的描述。 |

| 3 | 从上下文中获取操作失败时抛出的异常。 |

| 4 | 使用上下文提供的信息以任何相关方式报告故障。 |

| 5 | handle(EntityIndexingFailureContext)用于在索引实体时发生的故障。 |

| 6 | 除了失败的操作和异常之外,上下文还列出了由于故障而无法正确索引的实体的引用。 |

| 7 | 实体引用公开实体类型、名称和标识符。 |

| 8 | 实体引用可以使用toString()转换为人类可读的字符串。 |

| 9 | 使用上下文提供的信息以任何相关方式报告故障。 |

hibernate.search.background_failure_handler = class:org.hibernate.search.documentation.reporting.failurehandler.MyFailureHandler使用 Hibernate Search 配置属性分配背景故障处理程序。

|

当故障处理程序的 |

8.5.2. 多租户

如果您的应用程序使用 Hibernate ORM 的多租户支持,或者如果您在独立 POJO 映射器中显式配置了多租户,Hibernate Search 应该检测到并透明地配置您的后端。有关详细信息,请参阅

在某些情况下,特别是在使用outbox-polling协调策略或期望批量索引器隐式地针对所有租户时,您需要显式列出应用程序可能使用的所有租户标识符。Hibernate Search 在生成应将操作应用于每个租户的后台进程时使用此信息。

标识符列表通过以下配置属性定义

hibernate.search.multi_tenancy.tenant_ids = mytenant1,mytenant2,mytenant3此属性可以设置为包含多个租户标识符(以逗号分隔)的字符串,也可以设置为包含租户标识符的Collection<String>。

9. 主 API 入口点

本节详细介绍了 Hibernate Search API 在运行时的主要入口点,即用于索引、搜索、查找元数据等的 API。

9.1. SearchMapping

9.1.1. 基础知识

SearchMapping是 Hibernate Search API 的最高级入口点:它表示实体到索引的整个映射。

SearchMapping是线程安全的:它可以安全地从多个线程并发使用。但是,这并不意味着它返回的对象(SearchWorkspace,…)本身是线程安全的。

|

Hibernate Search 中的 |

|

一些框架,例如Quarkus,允许您只需将 |

9.1.2. 使用 Hibernate ORM 集成检索SearchMapping

使用Hibernate ORM 集成,SearchMapping在Hibernate ORM 启动时自动创建。

要检索SearchMapping,请调用Search.mapping(…)并传递EntityManagerFactory/SessionFactory

SessionFactory检索SearchMappingSessionFactory sessionFactory = /* ... */ (1)

SearchMapping searchMapping = Search.mapping( sessionFactory ); (2)| 1 | 检索SessionFactory。详细信息取决于您的框架,但这通常通过将其注入到您自己的类中来实现,例如,通过使用@Inject或@PersistenceUnit注解某个该类型的字段。 |

| 2 | 调用Search.mapping(…),将SessionFactory作为参数传递。这将返回SearchMapping。 |

仍然使用Hibernate ORM 集成,可以从 JPA EntityManagerFactory执行相同的操作

EntityManagerFactory检索SearchMappingEntityManagerFactory entityManagerFactory = /* ... */ (1)

SearchMapping searchMapping = Search.mapping( entityManagerFactory ); (2)| 1 | 检索EntityManagerFactory。详细信息取决于您的框架,但这通常通过将其注入到您自己的类中来实现,例如,通过使用@Inject或@PersistenceUnit注解某个该类型的字段。 |

| 2 | 调用Search.mapping(…),将EntityManagerFactory作为参数传递。这将返回SearchMapping。 |

9.1.3. 使用独立 POJO 映射器检索SearchMapping

使用独立 POJO 映射器,SearchMapping是启动 Hibernate Search 的结果。

有关使用独立 POJO 映射器启动 Hibernate Search 的更多信息,请参阅本节。

9.2. SearchSession

9.2.1. 基础知识

SearchSession表示执行一系列相关操作的上下文。它通常应该用于很短的时间,例如处理单个 Web 请求。

SearchSession不是线程安全的:它不能从多个线程并发使用。

|

Hibernate Search 中的 |

|

一些框架,例如Quarkus,允许您只需将 |

9.2.2. 使用 Hibernate ORM 集成检索SearchSession

要使用Hibernate ORM 集成检索SearchSession,请调用Search.session(…)并传递EntityManager/Session

Session检索SearchSessionSession session = /* ... */ (1)

SearchSession searchSession = Search.session( session ); (2)| 1 | 检索Session。详细信息取决于您的框架,但这通常通过将其注入到您自己的类中来实现,例如,通过使用@Inject或@PersistenceContext注解某个该类型的字段。 |

| 2 | 调用Search.session(…),将Session作为参数传递。这将返回SearchSession。 |

仍然使用Hibernate ORM 集成,可以从 JPA EntityManager执行相同的操作

EntityManager检索SearchSessionEntityManager entityManager = /* ... */ (1)

SearchSession searchSession = Search.session( entityManager ); (2)| 1 | 检索EntityManager。详细信息取决于您的框架,但这通常通过将其注入到您自己的类中来实现,例如,通过使用@Inject或@PersistenceContext注解某个该类型的字段。 |

| 2 | 调用Search.mapping(…),将EntityManager作为参数传递。这将返回SearchSession。 |

9.2.3. 使用独立 POJO 映射器检索SearchSession

使用 独立 POJO 映射器 时,应显式创建和关闭 SearchSession。

SearchSessionSearchMapping searchMapping = /* ... */ (1)

try ( SearchSession searchSession = searchMapping.createSession() ) { (2)

// ...

}| 1 | 检索 SearchMapping. |

| 2 | 创建一个新会话。请注意,我们使用的是 try-with-resources 块,因此会话将在我们完成操作时自动关闭,这将特别触发 索引计划 的执行。 |

|

忘记关闭 |

SearchSession 也可以配置一些选项。

SearchSessionSearchMapping searchMapping = /* ... */ (1)

Object tenantId = "myTenant";

try ( SearchSession searchSession = searchMapping.createSessionWithOptions() (2)

.indexingPlanSynchronizationStrategy( IndexingPlanSynchronizationStrategy.sync() )(3)

.tenantId( tenantId )

.build() ) { (4)

// ...

}| 1 | 检索 SearchMapping. |

| 2 | 开始创建一个新会话。请注意,我们使用的是 try-with-resources 块,因此会话将在我们完成操作时自动关闭,这将特别触发 索引计划 的执行。 |

| 3 | 将选项传递给新会话。 |

| 4 | 构建新会话。 |

9.3. SearchScope

SearchScope 表示一组索引实体及其索引。

SearchScope 是线程安全的:它可以安全地从多个线程并发使用。但是,这并不意味着它返回的对象(SearchWorkspace 等)本身是线程安全的。

可以从 SearchMapping 以及 SearchSession 中检索 SearchScope。

SearchMapping 中检索 SearchScopeSearchMapping searchMapping = /* ... */ (1)

SearchScope<Book> bookScope = searchMapping.scope( Book.class ); (2)

SearchScope<Person> associateAndManagerScope = searchMapping.scope( Arrays.asList( Associate.class, Manager.class ) ); (3)

SearchScope<Person> personScope = searchMapping.scope( Person.class ); (4)

SearchScope<Person> personSubTypesScope = searchMapping.scope( Person.class,

Arrays.asList( "Manager", "Associate" ) ); (5)

SearchScope<Object> allScope = searchMapping.scope( Object.class ); (6)| 1 | 检索 SearchMapping. |

| 2 | 创建一个仅针对 Book 实体类型的 SearchScope。 |

| 3 | 创建一个同时针对 Associate 实体类型和 Manager 实体类型的 SearchScope。作用域的泛型类型参数可以是这些实体类型的任何公共超类型。 |

| 4 | 作用域始终会针对给定类的所有子类型,并且给定类本身不必是索引实体类型。这将创建一个 SearchScope,它针对 Person 接口的所有(索引实体)子类型;在我们的例子中,这将同时针对 Associate 实体类型和 Manager 实体类型。 |

| 5 | 对于高级用例,可以按名称针对实体类型。对于 Hibernate ORM,这将是 JPA 实体名称,对于 独立 POJO 映射器,这将是 实体定义 时分配给实体类型的名称。在这两种情况下,实体名称默认情况下都是 Java 类的简单名称。 |

| 6 | 传递 Object.class 将创建一个针对每个索引实体类型的作用域。 |

SearchSession 中检索 SearchScopeSearchSession searchSession = /* ... */ (1)

SearchScope<Book> bookScope = searchSession.scope( Book.class ); (2)

SearchScope<Person> associateAndManagerScope =

searchSession.scope( Arrays.asList( Associate.class, Manager.class ) ); (3)

SearchScope<Person> personScope = searchSession.scope( Person.class ); (4)

SearchScope<Person> personSubTypesScope = searchSession.scope( Person.class,

Arrays.asList( "Manager", "Associate" ) ); (5)

SearchScope<Object> allScope = searchSession.scope( Object.class ); (6)| 1 | 检索 SearchSession. |

| 2 | 创建一个仅针对 Book 实体类型的 SearchScope。 |

| 3 | 创建一个同时针对 Associate 实体类型和 Manager 实体类型的 SearchScope。作用域的泛型类型参数可以是这些实体类型的任何公共超类型。 |

| 4 | 作用域始终会针对给定类的所有子类型,并且给定类本身不必是索引实体类型。这将创建一个 SearchScope,它针对 Person 接口的所有(索引实体)子类型;在我们的例子中,这将同时针对 Associate 实体类型和 Manager 实体类型。 |

| 5 | 对于高级用例,可以按名称针对实体类型。对于 Hibernate ORM,这将是 JPA 实体名称,对于 独立 POJO 映射器,这将是 实体定义 时分配给实体类型的名称。在这两种情况下,实体名称默认情况下都是 Java 类的简单名称。 |

| 6 | 传递 Object.class 将创建一个针对每个索引实体类型的作用域。 |

10. 将实体映射到索引

10.1. 配置映射

10.1.1. 基于注释的映射

默认情况下,Hibernate Search 会自动处理实体类型的映射注释,以及这些实体类型中的嵌套类型,例如嵌入类型。

可以通过将 hibernate.search.mapping.process_annotations 设置为 Hibernate ORM 集成 的 false,或通过 AnnotationMappingConfigurationContext 设置为任何映射器来禁用基于注释的映射:请参阅 映射配置器 以访问该上下文,并参阅 AnnotationMappingConfigurationContext 的 javadoc 以了解可用选项。

|

如果禁用基于注释的映射,您可能需要以编程方式配置映射:请参阅 以编程方式映射。 |

Hibernate Search 还将尝试通过 类路径扫描 查找一些带注释的类型。

|

请参阅 实体定义、 实体/索引映射 和 使用 |

10.1.2. 类路径扫描

基础知识

Hibernate Search 会在启动时自动扫描实体类型的 JAR,查找使用“根映射注释”进行注释的类型,以便它可以自动将这些类型添加到应处理其注释的类型列表中。

根映射注释是充当映射入口点的映射注释,例如 @ProjectionConstructor 或 自定义根映射注释。如果没有此扫描,Hibernate Search 将在过晚时(当实际执行投影时)了解到投影构造函数,并且由于缺少元数据而失败。

扫描由 Jandex 支持,Jandex 是一个索引 JAR 内容的库。

扫描应用程序的依赖项

默认情况下,Hibernate Search 将仅扫描包含 Hibernate ORM 实体的 JAR。

如果希望 Hibernate Search 检测其他 JAR 中使用 根映射注释 进行注释的类型,则首先需要 访问 AnnotationMappingConfigurationContext。

从该上下文,您可以:

配置扫描

Hibernate Search 的扫描可能会在应用程序启动时通过 Jandex 触发 JAR 的索引。在一些更复杂的环境中,此索引可能无法访问要索引的类,或者可能会不必要地减慢启动速度。

在 Quarkus 或 Wildfly 中运行 Hibernate Search 有其优点,因为:

在其他情况下,根据应用程序需求,可以使用 Jandex Maven 插件在应用程序的构建阶段,以便在应用程序启动时索引已经构建并准备就绪。

或者,如果您的应用程序不使用 @ProjectionConstructor 或 自定义根映射注释,您可能希望完全或部分禁用此功能。

通常不建议这样做,因为它可能会导致引导失败或忽略映射注释,因为 Hibernate Search 将不再能够自动发现使用 根注释 进行注释的类型,这些类型位于没有嵌入式 Jandex 索引的 JAR 中。

为此,有两种选项可用:

-

将

hibernate.search.mapping.discover_annotated_types_from_root_mapping_annotations设置为false将禁用任何自动发现尝试,即使有可用的部分或完整的 Jandex 索引,这在根本没有使用根映射注释进行注释的类型,或者这些类型通过 映射配置器 或AnnotatedTypeSource显式列出时可能会有所帮助。 -

将

hibernate.search.mapping.build_missing_discovered_jandex_indexes设置为false将禁用启动时的 Jandex 索引构建,但仍将使用任何可用的预构建 Jandex 索引。这在需要部分自动发现时可能有所帮助,即可用的索引将用于发现,但没有可用索引的源将被忽略,除非它们的@ProjectionConstructor注释类型通过 映射配置器 或AnnotatedTypeSource显式列出。

10.1.3. 以编程方式映射

本文档中的大多数示例都使用基于注释的映射,这对于大多数应用程序来说通常已经足够了。但是,某些应用程序的需求超出了注释所能提供的范围:

-

单个实体类型必须针对不同的部署进行不同的映射(例如,针对不同的客户)。

-

许多实体类型必须以类似的方式进行映射,而无需代码重复。

为了满足这些需求,您可以使用以编程方式映射:通过将在启动时执行的代码定义映射。

以编程方式映射通过 ProgrammaticMappingConfigurationContext 配置:请参阅 映射配置器 以访问该上下文。

|

默认情况下,以编程方式映射将与基于注释的映射(如果有)合并。 要禁用基于注释的映射,请参阅 基于注释的映射。 |

|

以编程方式映射是声明性的,并公开了与基于注释的映射相同的特性。 为了实现更复杂的“命令式”映射,例如将两个实体属性组合成一个索引字段,请使用 自定义桥接。 |

|

或者,如果您只需要针对多个类型或属性重复相同的映射,则可以在这些类型或属性上应用自定义注释,并让 Hibernate Search 在遇到该注释时执行一些以编程方式映射的代码。此解决方案不需要特定于映射器的配置。 有关更多信息,请参阅 自定义映射注释。 |

10.1.4. 映射配置器

Hibernate ORM 集成

在 Hibernate ORM 集成中,可以将自定义 HibernateOrmSearchMappingConfigurer 插入 Hibernate Search,以便配置基于注释的映射(AnnotationMappingConfigurationContext)、以编程方式映射(ProgrammaticMappingConfigurationContext)等等。

插入自定义配置器需要两个步骤:

-

定义一个实现

org.hibernate.search.mapper.orm.mapping.HibernateOrmSearchMappingConfigurer接口的类。 -

通过将配置属性

hibernate.search.mapping.configurer设置为指向该实现的 bean 引用(例如class:com.mycompany.MyMappingConfigurer)来配置 Hibernate Search 以使用该实现。

| 您可以传递多个以逗号分隔的 bean 引用。请参阅 配置属性的类型。 |

Hibernate Search 将在启动时调用此实现的 configure 方法,配置器将能够利用 DSL 来配置基于注释的映射或定义以编程方式映射,例如:

public class MySearchMappingConfigurer implements HibernateOrmSearchMappingConfigurer {

@Override

public void configure(HibernateOrmMappingConfigurationContext context) {

ProgrammaticMappingConfigurationContext mapping = context.programmaticMapping(); (1)

TypeMappingStep bookMapping = mapping.type( Book.class ); (2)

bookMapping.indexed(); (3)

bookMapping.property( "title" ) (4)

.fullTextField().analyzer( "english" ); (5)

}

}独立 POJO 映射器

独立 POJO 映射器目前不提供 "映射配置器" (HSEARCH-4615)。但是,在构建 SearchMapping 时可以访问 AnnotationMappingConfigurationContext 和 ProgrammaticMappingConfigurationContext。

通过 Hibernate ORM 集成,可以将自定义的 StandalonePojoMappingConfigurer 插件到 Hibernate Search 中,以配置注解映射 (AnnotationMappingConfigurationContext)、编程映射 (ProgrammaticMappingConfigurationContext) 等。

插入自定义配置器需要两个步骤:

-

定义一个实现了

org.hibernate.search.mapper.pojo.standalone.mapping.StandalonePojoMappingConfigurer接口的类。 -

通过将配置属性

hibernate.search.mapping.configurer设置为指向该实现的 bean 引用(例如class:com.mycompany.MyMappingConfigurer)来配置 Hibernate Search 以使用该实现。

| 您可以传递多个以逗号分隔的 bean 引用。请参阅 配置属性的类型。 |

Hibernate Search 将在启动时调用此实现的 configure 方法,配置器将能够利用 DSL 来配置基于注释的映射或定义以编程方式映射,例如:

public class MySearchMappingConfigurer implements StandalonePojoMappingConfigurer {

@Override

public void configure(StandalonePojoMappingConfigurationContext context) {

context.annotationMapping() (1)

.discoverAnnotationsFromReferencedTypes( false )

.discoverAnnotatedTypesFromRootMappingAnnotations( false );

ProgrammaticMappingConfigurationContext mappingContext = context.programmaticMapping(); (2)

TypeMappingStep bookMapping = mappingContext.type( Book.class ); (3)

bookMapping.searchEntity(); (4)

bookMapping.indexed(); (5)

bookMapping.property( "id" ) (6)

.documentId(); (7)

bookMapping.property( "title" ) (8)

.fullTextField().analyzer( "english" ); (9)

}

}10.2. 实体定义

10.2.1. 基础知识

当 索引 Hibernate ORM 实体 时,实体类型由 Hibernate ORM 完全定义(通常通过 Jakarta 的 @Entity 注解),因此不需要显式定义:可以安全地跳过整个部分。

当使用 独立 POJO 映射器 时,需要 显式定义 实体类型。

10.2.2. 显式实体定义

|

以下详细介绍的功能处于 孵化 状态:它们仍在积极开发中。 通常的 兼容性策略 不适用:孵化元素(例如类型、方法、配置属性等)的契约可能会在后续版本中以向后不兼容的方式更改(甚至被删除)。 建议您使用孵化功能,以便开发团队可以获得反馈并改进它们,但您应该准备好根据需要更新依赖于它们的代码。 |

|

对于 Hibernate ORM 实体, 请查看 HSEARCH-5076 跟踪允许在 Hibernate ORM 集成中使用 |

使用 独立 POJO 映射器 时,必须使用 @SearchEntity 注解显式标记 实体类型。

@SearchEntity 将一个类标记为实体@SearchEntity (1)

@Indexed (2)

public class Book {| 1 | 使用 @SearchEntity 注解该类型。 |

| 2 | @Indexed 是可选的:只有在打算 将该类型映射到索引 时才需要它。 |

|

并非所有类型都是实体类型,即使它们具有复合结构。 错误地将类型标记为实体类型可能会迫使您为域模型添加不必要的复杂性,例如 定义标识符 或 为 "关联" 这些类型定义反向端,而这些关联不会被使用。 请务必阅读 本节,以了解有关实体类型的更多信息以及它们为什么是必要的。 |

|

子类不继承 每个子类也必须使用 但是,对于也使用 |

默认情况下,使用 独立 POJO 映射器 时

-

实体名称 将等于类的简单名称 (

java.lang.Class#getSimpleName)。 -

实体不会被配置为加载,无论是为了 在搜索查询中返回实体作为命中,还是为了 批量索引。

请参阅以下部分以覆盖这些默认值。

10.2.3. 实体名称

|

以下详细介绍的功能处于 孵化 状态:它们仍在积极开发中。 通常的 兼容性策略 不适用:孵化元素(例如类型、方法、配置属性等)的契约可能会在后续版本中以向后不兼容的方式更改(甚至被删除)。 建议您使用孵化功能,以便开发团队可以获得反馈并改进它们,但您应该准备好根据需要更新依赖于它们的代码。 |

与相应类名不同的 实体 名称,涉及多个地方,包括但不限于

-

作为

@Indexed的默认索引名称; -

使用 字符串来定位实体类型。

实体名称默认为类的简单名称 (java.lang.Class#getSimpleName)。

|

更改已 索引 实体的实体名称可能需要 完全重新索引,特别是在使用 Elasticsearch/OpenSearch 后端 时。 请参阅 本节 以了解详细信息。 |

通过 Hibernate ORM 集成,可以使用各种方法覆盖此名称,但通常是通过 Jakarta Persistence 的 @Entity 注解,即使用 @Entity(name = …)。

使用 独立 POJO 映射器 时,实体类型使用 @SearchEntity 定义,并且可以使用 @SearchEntity(name = …) 覆盖实体名称。

|

对于 Hibernate ORM 实体, 请查看 HSEARCH-5076 跟踪允许在 Hibernate ORM 集成中使用 |

@SearchEntity(name = …) 设置自定义实体名称@SearchEntity(name = "MyAuthorName")

@Indexed

public class Author {10.2.4. 批量加载策略

"批量加载策略" 使 Hibernate Search 能够加载给定类型的实体以进行 批量索引。

通过 Hibernate ORM 集成,会为每个 Hibernate ORM 实体自动配置批量加载策略,不需要任何其他配置。

使用 独立 POJO 映射器 时,实体类型使用 @SearchEntity 定义,为了利用批量索引,必须使用 @SearchEntity(loadingBinder = …) 显式应用批量加载策略。

|

以下详细介绍的功能处于 孵化 状态:它们仍在积极开发中。 通常的 兼容性策略 不适用:孵化元素(例如类型、方法、配置属性等)的契约可能会在后续版本中以向后不兼容的方式更改(甚至被删除)。 建议您使用孵化功能,以便开发团队可以获得反馈并改进它们,但您应该准备好根据需要更新依赖于它们的代码。 |

|

对于 Hibernate ORM 实体, 请查看 HSEARCH-5076 跟踪允许在 Hibernate ORM 集成中使用 |

@SearchEntity(loadingBinder = @EntityLoadingBinderRef(type = MyLoadingBinder.class)) (1)

@Indexed

public class Book {| 1 | 为实体分配一个加载绑定器。 |

| 子类继承其父类的加载绑定器,除非它们使用自己的加载绑定器进行覆盖。 |

@Singleton

public class MyLoadingBinder implements EntityLoadingBinder { (1)

private final MyDatastore datastore;

@Inject (2)

public MyLoadingBinder(MyDatastore datastore) {

this.datastore = datastore;

}

@Override

public void bind(EntityLoadingBindingContext context) { (3)

context.massLoadingStrategy( (4)

Book.class, (5)

new MyMassLoadingStrategy<>( datastore, Book.class ) (6)

);

}

}| 1 | 绑定器必须实现 EntityLoadingBinder 接口。 |

| 2 | 将特定于实现的数据存储注入加载绑定器,例如这里使用 CDI(或 Spring 上的 @Autowired,或者 …)。 |

| 3 | 实现 bind 方法。 |

| 4 | 调用 context.massLoadingStrategy(…) 以定义要使用的加载策略。 |

| 5 | 传递加载实体的预期超类型。 |

| 6 | 传递加载策略。 |

使用 独立 POJO 映射器 在加载绑定器中进行注入需要 通过其他配置提供一个 BeanProvider。 |

以下是一个针对假想数据存储的 MassLoadingStrategy 实现示例。

MassLoadingStrategypublic class MyMassLoadingStrategy<E>

implements MassLoadingStrategy<E, String> {

private final MyDatastore datastore; (1)

private final Class<E> rootEntityType;

public MyMassLoadingStrategy(MyDatastore datastore, Class<E> rootEntityType) {

this.datastore = datastore;

this.rootEntityType = rootEntityType;

}

@Override

public MassIdentifierLoader createIdentifierLoader(

LoadingTypeGroup<E> includedTypes, (2)

MassIdentifierSink<String> sink, MassLoadingOptions options) {

int batchSize = options.batchSize(); (3)

Collection<Class<? extends E>> typeFilter =

includedTypes.includedTypesMap().values(); (4)

return new MassIdentifierLoader() {

private final MyDatastoreConnection connection =

datastore.connect(); (5)

private final MyDatastoreCursor<String> identifierCursor =

connection.scrollIdentifiers( typeFilter );

@Override

public void close() {

connection.close(); (5)

}

@Override

public long totalCount() { (6)

return connection.countEntities( typeFilter );

}

@Override

public void loadNext() throws InterruptedException {

List<String> batch = identifierCursor.next( batchSize );

if ( batch != null ) {

sink.accept( batch ); (7)

}

else {

sink.complete(); (8)

}

}

};

}

@Override

public MassEntityLoader<String> createEntityLoader(

LoadingTypeGroup<E> includedTypes, (9)

MassEntitySink<E> sink, MassLoadingOptions options) {

return new MassEntityLoader<String>() {

private final MyDatastoreConnection connection =

datastore.connect(); (10)

@Override

public void close() { (8)

connection.close();

}

@Override

public void load(List<String> identifiers)

throws InterruptedException {

sink.accept( (11)

connection.loadEntitiesById( rootEntityType, identifiers )

);

}

};

}

}| 1 | 该策略必须能够访问数据存储以打开连接,但它通常不应该有任何打开的连接。 |

| 2 | 实现一个标识符加载器以检索所有需要索引的实体的标识符。Hibernate Search 仅会对每个批量索引调用此方法一次。 |

| 3 | 检索在 MassIndexer 上配置的 批量大小。这定义了每次传递给接收器的 List 中最多必须返回多少个 ID。 |

| 4 | 检索要加载的实体类型列表:如果这些类型共享相似的批量加载策略,Hibernate Search 可能会从单个加载器请求加载多个类型(请参阅以下提示/警告)。 |

| 5 | 标识符加载器独占地拥有连接:它应该在创建时创建一个连接,并在关闭时关闭它。相关内容:标识符加载器始终在同一个线程中执行。 |

| 6 | 计算要索引的实体数量。这只是一个估计:它可能存在一定程度的偏差,但会导致 监视器(默认情况下,日志)中的报告不正确。 |

| 7 | 以连续的批次检索标识符,每次调用 loadNext() 时检索一个批次,并将它们传递给接收器。 |

| 8 | 当没有更多标识符要加载时,通过调用 complete() 让接收器知道。 |

| 9 | 实现一个实体加载器,以实际从上面检索到的标识符加载实体。Hibernate Search 将为单个批量索引调用此方法多次,以创建 多个加载器,这些加载器并行执行。 |

| 10 | 每个实体加载器独占地拥有一个连接:它应该在创建时创建一个连接,并在关闭时关闭它。相关内容:每个实体加载器始终在同一个线程中执行。 |

| 11 | 加载与传递给参数的标识符相对应的实体,并将它们传递给接收器。传递给接收器的实体不需要与传递给参数的标识符具有相同的顺序。 |

|

Hibernate Search 将通过将具有相同 当将类型分组在一起时,只会调用其中一个策略,并且它将获得一个包含所有应加载的类型的 "类型组"。 这种情况特别发生在从 "父" 实体类型配置的加载绑定器被子类型继承,并在子类型上设置相同的策略时。 |

|

小心继承树中非抽象(可实例化)的父类:当传递给 |

一旦所有要重新索引的类型都实现了其批量加载策略并被分配,就可以使用 批量索引器 来重新索引它们。

SearchMapping searchMapping = /* ... */ (1)

searchMapping.scope( Object.class ).massIndexer() (2)

.startAndWait(); (3)| 1 | 检索 SearchMapping. |

| 2 | 创建一个针对每个已索引实体类型的 MassIndexer。 |

| 3 | 启动批量索引过程,并在其结束后返回。 |

10.2.5. 选择加载策略

"选择加载策略" 使 Hibernate Search 能够加载给定类型的实体,以 在搜索查询中返回从外部来源加载的实体作为命中。

通过 Hibernate ORM 集成,会为每个 Hibernate ORM 实体自动配置选择加载策略,不需要任何其他配置。

使用 独立 POJO 映射器 时,实体类型使用 @SearchEntity 定义,为了在搜索查询中返回从外部来源加载的实体,必须使用 @SearchEntity(loadingBinder = …) 显式应用选择加载策略。

|

以下详细介绍的功能处于 孵化 状态:它们仍在积极开发中。 通常的 兼容性策略 不适用:孵化元素(例如类型、方法、配置属性等)的契约可能会在后续版本中以向后不兼容的方式更改(甚至被删除)。 建议您使用孵化功能,以便开发团队可以获得反馈并改进它们,但您应该准备好根据需要更新依赖于它们的代码。 |

|

对于 Hibernate ORM 实体, 请查看 HSEARCH-5076 跟踪允许在 Hibernate ORM 集成中使用 |

@SearchEntity(loadingBinder = @EntityLoadingBinderRef(type = MyLoadingBinder.class)) (1)

@Indexed

public class Book {| 1 | 为实体分配一个加载绑定器。 |

| 子类继承其父类的加载绑定器,除非它们使用自己的加载绑定器进行覆盖。 |

@Singleton

public class MyLoadingBinder implements EntityLoadingBinder { (1)

@Override

public void bind(EntityLoadingBindingContext context) { (2)

context.selectionLoadingStrategy( (3)

Book.class, (4)

new MySelectionLoadingStrategy<>( Book.class ) (5)

);

}

}| 1 | 绑定器必须实现 EntityLoadingBinder 接口。 |

| 2 | 实现 bind 方法。 |

| 3 | 调用 context.selectionLoadingStrategy(…) 以定义要使用的加载策略。 |

| 4 | 传递加载实体的预期超类型。 |

| 5 | 传递加载策略。 |

以下是一个针对假想数据存储的 SelectionLoadingStrategy 实现示例。

SelectionLoadingStrategypublic class MySelectionLoadingStrategy<E>

implements SelectionLoadingStrategy<E> {

private final Class<E> rootEntityType;

public MySelectionLoadingStrategy(Class<E> rootEntityType) {

this.rootEntityType = rootEntityType;

}

@Override

public SelectionEntityLoader<E> createEntityLoader(

LoadingTypeGroup<E> includedTypes, (1)

SelectionLoadingOptions options) {

MyDatastoreConnection connection =

options.context( MyDatastoreConnection.class ); (2)

return new SelectionEntityLoader<E>() {

@Override

public List<E> load(List<?> identifiers, Deadline deadline) {

return connection.loadEntitiesByIdInSameOrder( (3)

rootEntityType, identifiers );

}

};

}

}| 1 | 实现一个实体加载器,以实际从 Lucene/Elasticsearch 返回的标识符加载实体。Hibernate Search 将为单个批量索引调用此方法多次, |

| 2 | 实体加载器不拥有连接,而是从传递给 SearchSession 的上下文中检索它(请参阅下一个示例)。 |

| 3 | 加载与传递给参数的标识符相对应的实体,并将其返回。返回的实体必须与传递给参数的标识符具有相同的顺序。 |

|

Hibernate Search 会通过将具有相同 当将类型分组在一起时,只会调用其中一个策略,并且它将获得一个包含所有应加载的类型的 "类型组"。 这种情况特别发生在从 "父" 实体类型配置的加载绑定器被子类型继承,并在子类型上设置相同的策略时。 |

一旦所有要搜索的类型都实现了并分配了它们的selection加载策略,就可以在查询时将其加载为命中项。

MyDatastore datastore = /* ... */ (1)

SearchMapping searchMapping = /* ... */ (2)

try ( MyDatastoreConnection connection = datastore.connect(); (3)

SearchSession searchSession = searchMapping.createSessionWithOptions() (4)

.loading( o -> o.context( MyDatastoreConnection.class, connection ) ) (5)

.build() ) { (6)

List<Book> hits = searchSession.search( Book.class ) (7)

.where( f -> f.matchAll() )

.fetchHits( 20 ); (8)

}| 1 | 检索对特定于实现的数据存储的引用。 |

| 2 | 检索 SearchMapping. |

| 3 | 打开与数据存储的连接(这只是一个虚构的 API,用于此示例的目的)。请注意,我们使用 try-with-resources 块,以便在完成操作后自动关闭连接。 |

| 4 | 开始创建新的会话。请注意,我们使用 try-with-resources 块,以便在完成操作后自动关闭会话。 |

| 5 | 将连接传递给新会话。 |

| 6 | 构建新会话。 |

| 7 | 创建搜索查询:由于我们不使用select(),命中项将具有其默认表示形式:从数据存储加载的实体。 |

| 8 | 检索从数据存储加载的实体作为搜索命中项。 |

10.2.6. 编程映射

|

以下详细介绍的功能处于 孵化 状态:它们仍在积极开发中。 通常的 兼容性策略 不适用:孵化元素(例如类型、方法、配置属性等)的契约可能会在后续版本中以向后不兼容的方式更改(甚至被删除)。 建议您使用孵化功能,以便开发团队可以获得反馈并改进它们,但您应该准备好根据需要更新依赖于它们的代码。 |

|

对于 Hibernate ORM 实体, 请查看 HSEARCH-5076 跟踪允许在 Hibernate ORM 集成中使用 |

您也可以通过编程映射将类型标记为实体类型。行为和选项与基于注释的映射相同。

.searchEntity()将类型标记为实体类型TypeMappingStep bookMapping = mapping.type( Book.class );

bookMapping.searchEntity();

TypeMappingStep authorMapping = mapping.type( Author.class );

authorMapping.searchEntity().name( "MyAuthorName" );10.3. 实体/索引映射

10.3.1. 基础

为了索引实体,必须使用@Indexed对其进行注释。

@Indexed标记要索引的类@Entity

@Indexed

public class Book {|

子类继承 如果 |

默认情况下

-

索引名称将等于实体名称,在 Hibernate ORM 中,实体名称是使用

@Entity注释设置的,默认为简单类名。 -

使用Hibernate ORM 集成时,索引文档的标识符将从实体标识符生成。大多数用于实体标识符的常见类型都开箱即用地支持,但对于更奇特的类型,您可能需要特定的配置。

使用独立 POJO 映射器时,索引文档的标识符需要显式映射。

有关详细信息,请参阅映射文档标识符。

-

索引将不包含任何字段。必须将字段显式映射到属性。有关详细信息,请参阅使用

@GenericField、@FullTextField等将属性映射到索引字段。

10.3.2. 显式索引/后端

您可以通过设置@Indexed(index = …)来更改索引的名称。请注意,索引名称在给定应用程序中必须是唯一的。

@Indexed.index指定显式索引名称@Entity

@Indexed(index = "AuthorIndex")

public class Author {如果您定义了命名后端,您可以将实体映射到默认后端以外的其他后端。通过设置@Indexed(backend = "backend2"),您通知 Hibernate Search 您的实体的索引必须在名为“backend2”的后端中创建。如果您的模型具有明确定义的子部分并且具有非常不同的索引需求,这可能很有用。

@Indexed.backend指定显式后端@Entity

@Table(name = "\"user\"")

@Indexed(backend = "backend2")

public class User {|

索引在不同后端中的实体不能被同一个查询目标。例如,使用上面定义的映射,以下代码将抛出异常,因为 |

10.3.3. 条件索引和路由

将实体映射到索引并不总是像“此实体类型映射到此索引”那样简单。由于多种原因,主要是出于性能原因,您可能希望自定义何时以及在何处索引给定实体。

-

您可能不希望索引给定类型的所有实体:例如,当实体的

status属性设置为DRAFT或ARCHIVED时,阻止对其进行索引,因为用户不应该搜索这些实体。 -

您可能希望将实体路由到索引的特定分片:例如,根据实体的

language属性对其进行路由,因为每个用户都有特定的语言,并且只搜索其语言的实体。

这些行为可以通过使用@Indexed(routingBinder = …)将路由桥分配给索引的实体类型来在 Hibernate Search 中实现。

有关路由桥的更多信息,请参阅路由桥。

10.3.4. 编程映射

您也可以通过编程映射将实体标记为索引。行为和选项与基于注释的映射相同。

.indexed()标记要索引的类TypeMappingStep bookMapping = mapping.type( Book.class );

bookMapping.indexed();

TypeMappingStep authorMapping = mapping.type( Author.class );

authorMapping.indexed().index( "AuthorIndex" );

TypeMappingStep userMapping = mapping.type( User.class );

userMapping.indexed().backend( "backend2" );10.4. 映射文档标识符

10.4.1. 基础

索引文档,就像实体一样,需要分配一个标识符,以便 Hibernate Search 可以处理更新和删除。

当索引 Hibernate ORM 实体时,实体标识符默认用作文档标识符。只要实体标识符具有受支持的类型,标识符映射将开箱即用,无需显式映射。

当使用独立 POJO 映射器时,文档标识符需要显式映射。

10.4.2. 显式标识符映射

在以下情况下需要显式标识符映射。

-

Hibernate Search 不了解实体标识符(例如,当使用独立 POJO 映射器时)。

-

或者文档标识符不是实体标识符。

-

或者实体标识符的类型不受默认支持。这种情况包括复合标识符(Hibernate ORM 的

@EmbeddedId、@IdClass),尤其是复合标识符。

要选择一个要映射到文档标识符的属性,只需将@DocumentId注释应用到该属性即可。

@DocumentId显式将属性映射到文档标识符@Entity

@Indexed

public class Book {

@Id

@GeneratedValue

private Integer id;

@NaturalId

@DocumentId

private String isbn;

public Book() {

}

// Getters and setters

// ...

}当属性类型不受支持时,还需要实现自定义标识符桥,然后在@DocumentId注释中引用它。

@DocumentId将具有不受支持类型的属性映射到文档标识符@Entity

@Indexed

public class Book {

@Id

@Convert(converter = ISBNAttributeConverter.class)

@DocumentId(identifierBridge = @IdentifierBridgeRef(type = ISBNIdentifierBridge.class))

private ISBN isbn;

public Book() {

}

// Getters and setters

// ...

}10.4.3. 支持的标识符属性类型

以下是具有内置标识符桥的类型列表,即在将属性映射到文档标识符时开箱即用地支持的属性类型。

该表还解释了分配给文档标识符的值,即传递给底层后端的值。

| 属性类型 | 文档标识符的值 | 限制 |

|---|---|---|

|

|

- |

|

不变 |

- |

|

一个单字符 |

- |

|

|

- |

|

|

- |

|

|

- |

|

|

- |

|

|

- |

|

|

- |

|

|

- |

|

|

- |

|

|

- |

|

|

- |

|

|

- |

|

根据 |

- |

|

根据 |

- |

|

根据 |

- |

|

根据 |

- |

|

根据 |

- |

|

根据 |

- |

|

根据 |

- |

|

|

- |

|

|

- |

|

根据ISO 8601 格式的持续时间(例如 |

- |

|

根据ISO 8601 格式的持续时间进行格式化,仅使用秒和纳秒(例如 |

- |

|

根据ISO 8601 格式的年份(例如,对于公元 2017 年为 |

- |

|

根据ISO 8601 格式的年月(例如,对于 2017 年 11 月为 |

- |

|

根据ISO 8601 格式的月日(例如,对于 11 月 6 日为 |

- |

|

|

- |

|

一个表示相同日期/时间和时区的 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

纬度作为双精度数,经度作为双精度数,用逗号分隔(例如 |

- |

10.4.4. 编程映射

您也可以通过编程映射映射文档标识符。行为和选项与基于注释的映射相同。

.documentId()显式将属性映射到文档标识符TypeMappingStep bookMapping = mapping.type( Book.class );

bookMapping.indexed();

bookMapping.property( "isbn" ).documentId();10.5. 使用@GenericField、@FullTextField 等将属性映射到索引字段

10.5.1. 基础

实体的属性可以直接映射到索引字段:您只需要添加一个注释,通过注释属性配置字段,Hibernate Search 将负责提取属性值并在必要时填充索引字段。

将属性映射到索引字段看起来像这样

@FullTextField(analyzer = "english", projectable = Projectable.YES) (1)

@KeywordField(name = "title_sort", normalizer = "english", sortable = Sortable.YES) (2)

private String title;

@GenericField(projectable = Projectable.YES, sortable = Sortable.YES) (3)

private Integer pageCount;| 1 | 将title属性映射到具有相同名称的全文本字段。可以设置一些选项来自定义字段的行为,在本例中是分析器(用于全文本索引)以及该字段是可投影的(其值可以从索引中检索)这一事实。 |

| 2 | 将title属性映射到另一个字段,以不同的方式配置:它没有被分析,而是简单地被规范化(即它没有被拆分为多个标记),并且它以可以用于排序的方式存储。将单个属性映射到多个字段在进行全文搜索时特别有用:在查询时,您可以根据需要使用不同的字段。您可以将一个属性映射到任意多个字段,但每个字段必须具有唯一的名称。 |

| 3 | 将另一个属性映射到其自己的字段。 |

在映射属性之前,您需要考虑两件事

@*Field注解-

在最简单的形式中,属性/字段映射是通过将

@GenericField注解应用于属性来实现的。此注解适用于所有支持的属性类型,但功能有限:它尤其不允许全文搜索。要更进一步,您需要依赖不同的、更具体的注解,这些注解提供特定的属性。可用的注解在 可用字段注解 中详细描述。 - 属性的类型

-

为了使

@*Field注解能够正常工作,映射属性的类型必须得到 Hibernate Search 的支持。有关所有开箱即用支持的类型的列表,请参阅 支持的属性类型,有关如何处理更复杂类型的说明,请参阅 映射自定义属性类型,无论是简单的容器(List<String>、Map<String, Integer>、……)还是自定义类型。

10.5.2. 可用字段注解

存在各种字段注解,每个注解都提供自己的一组属性。

本节列出了不同的注解及其用途。有关可用属性的更多详细信息,请参阅 字段注解属性。

@GenericField-

一个很好的默认选择,适用于所有具有内置支持的属性类型。

使用此注解映射的字段不提供任何高级功能,例如全文搜索:对通用字段的匹配是精确匹配。

-

@FullTextField -

一个文本字段,其值被视为多个词语。仅适用于

String字段。对全文字段的匹配可以 比精确匹配更微妙:匹配包含给定词语的字段,匹配不区分大小写的字段,匹配忽略变音符号的字段,……

全文字段还允许 突出显示。

全文字段应分配一个 分析器,由其名称引用。默认情况下,将使用名为

default的分析器。有关分析器和全文分析的更多详细信息,请参阅 分析。有关如何更改默认分析器的说明,请参阅您后端的文档中的专用部分:Lucene 或 Elasticsearch注意,您还可以定义 搜索分析器 以不同地分析搜索词语。

全文字段不能被排序或聚合。如果您需要根据属性的值进行排序或聚合,建议使用 @KeywordField,如果需要,可以使用规范化器(见下文)。请注意,可以向同一个属性添加多个字段,因此如果您需要全文搜索和排序,可以使用@FullTextField和@KeywordField:您只需要为这两个字段使用不同的 名称。 -

@KeywordField -

一个文本字段,其值被视为单个关键字。仅适用于

String字段。 -

@ScaledNumberField -

一个数值字段,用于需要比双精度数更高的精度的整数或浮点数,但始终具有大致相同的比例。仅适用于

java.math.BigDecimal或java.math.BigInteger字段。缩放数字被索引为整数,通常是长整型(64 位),具有固定的比例,该比例在所有文档中跨所有字段的所有值保持一致。由于缩放数字是以固定精度索引的,因此它们不能表示所有

BigDecimal或BigInteger值。太大的值无法索引,将触发运行时异常。具有尾随小数位的数字将四舍五入到最接近的整数。此注解允许设置 decimalScale 属性。

@NonStandardField-

一个注解,用于高级用例,其中使用 值绑定器,并且该绑定器预计会定义一个不支持任何标准选项的索引字段类型:

searchable、sortable、……此注解对于需要后端本机字段类型的用例非常有用:直接将映射定义为 JSON 用于 Elasticsearch,或 直接操作

IndexableField用于 Lucene。使用此注解映射的字段从注解中具有非常有限的配置选项(没有

searchable/sortable/等),但值绑定器将能够选择非标准字段类型,这通常会提供更大的灵活性。 -

@VectorField -

以下详细介绍的功能处于 孵化 状态:它们仍在积极开发中。

通常的 兼容性策略 不适用:孵化元素(例如类型、方法、配置属性等)的契约可能会在后续版本中以向后不兼容的方式更改(甚至被删除)。

建议您使用孵化功能,以便开发团队可以获得反馈并改进它们,但您应该准备好根据需要更新依赖于它们的代码。

向量字段的特定字段类型,用于 向量搜索。

向量字段接受类型为

float[]或byte[]的值,并且**要求**预先指定存储向量的 维数,并且索引向量的尺寸要与该维数匹配。除此之外,向量字段还允许可选地配置搜索过程中使用的 相似性函数,

efConstruction和m用于索引。不允许在同一个字段内索引多个向量,即向量字段不能是 多值。

10.5.3. 字段注解属性

存在各种字段映射注解,每个注解都提供自己的一组属性。

本节列出了不同的注解属性及其用途。有关可用注解的更多详细信息,请参阅 可用字段注解。

-

name -

索引字段的名称。默认情况下,它与属性名称相同。您可能希望在将单个属性映射到多个字段时更改它。

值:

String。名称不得包含句点字符(.)。默认为属性的名称。 -

sortable -

该字段是否可以 排序,即索引中是否添加了特定的数据结构,以便在查询时允许高效的排序。

值:

Sortable.YES、Sortable.NO、Sortable.DEFAULT。此选项不适用于

@FullTextField。有关解释和一些解决方案,请参阅 此处。 -

projectable -

该字段是否可以 投影,即该字段值是否存储在索引中,以便在查询时允许以后检索。

值:

Projectable.YES、Projectable.NO、Projectable.DEFAULT。对于 Lucene 和 Elasticsearch 后端,默认值不同:对于 Lucene,默认值为

Projectable.NO,而对于 Elasticsearch,默认值为Projectable.YES。对于 Elasticsearch,如果在

GeoPoint字段上将projectable或sortable属性解析为YES,那么即使其中一个显式设置为NO,此字段也会自动同时变为projectable和sortable。 -

aggregable -

该字段是否可以 聚合,即该字段值是否存储在索引中特定数据结构中,以便在查询时允许以后聚合。

值:

Aggregable.YES、Aggregable.NO、Aggregable.DEFAULT。此选项不适用于

@FullTextField。有关解释和一些解决方案,请参阅 此处。 searchable-

该字段是否可以被搜索。即该字段是否被索引,以便在查询时允许以后应用谓词。

值:

Searchable.YES、Searchable.NO、Searchable.DEFAULT。 -

indexNullAs -

用于替代任何时候属性值为 null 的值。

默认情况下禁用。

替换被定义为字符串。因此,它的值必须被解析。在 支持的属性类型 中查找列“indexNullAs”的解析方法,以了解解析时使用的格式。

-

extraction -

对于容器类型(

List、Optional、Map、……),如何从属性中提取要索引的元素。默认情况下,对于具有容器类型的属性,将索引最里面的元素。例如,对于类型为

List<String>的属性,将索引类型为String的元素。向量字段默认情况下禁用提取。

本节描述了此默认行为以及覆盖它的方法: 使用容器提取器映射容器类型。

-

analyzer -

在索引和查询时应用于字段值的分析器。仅适用于

@FullTextField。默认情况下,将使用名为

default的分析器。有关分析器和全文分析的更多详细信息,请参阅 分析。

-

searchAnalyzer -

一个可选的不同的分析器,覆盖使用

analyzer属性定义的分析器,仅在分析搜索词语时使用。如果未定义,则将使用分配给

analyzer的分析器。有关分析器和全文分析的更多详细信息,请参阅 分析。

-

normalizer -

在索引和查询时应用于字段值的规范化器。仅适用于

@KeywordField。有关规范化器和全文分析的更多详细信息,请参阅 分析。

norms-

是否存储字段的索引时评分信息。仅适用于

@KeywordField和@FullTextField。启用规范将提高评分质量。禁用规范将减少索引使用的磁盘空间。

值:

Norms.YES、Norms.NO、Norms.DEFAULT。 termVector-

词语向量存储策略。仅适用于

@FullTextField。此属性的不同值是

值 定义 TermVector.YES存储每个文档的词向量。这将生成两个同步的数组,一个包含文档词语,另一个包含词语的频率。

TermVector.NO不存储词向量。

TermVector.WITH_POSITIONS存储词向量和标记位置信息。这与

TermVector.YES相同,它还包含每个词语在文档中出现的顺序位置。TermVector.WITH_OFFSETS存储词向量和标记偏移量信息。这与

TermVector.YES相同,它还包含词语的起始和结束偏移量位置信息。TermVector.WITH_POSITION_OFFSETS存储词向量、标记位置和偏移量信息。这是

YES、WITH_OFFSETS和WITH_POSITIONS的组合。TermVector.WITH_POSITIONS_PAYLOADS存储词向量、标记位置和标记有效载荷。这与

TermVector.WITH_POSITIONS相同,它还包含每个词语在文档中出现的有效载荷。TermVector.WITH_POSITIONS_OFFSETS_PAYLOADS存储词向量、标记位置、偏移量信息和标记有效载荷。这与

TermVector.WITH_POSITION_OFFSETS相同,它还包含每个词语在文档中出现的有效载荷。请注意,全文字段请求的突出显示类型可能会影响最终解析的词向量存储策略。由于快速向量突出显示器类型对词向量存储策略有特定要求,如果通过使用

Highlightable.ANY显式或隐式请求它,它将把策略设置为TermVector.WITH_POSITIONS_OFFSETS,除非已指定策略。如果使用与快速向量突出显示器不兼容的非默认策略,则会抛出异常。 -

decimalScale -

在将大数(

BigInteger或BigDecimal)索引为固定精度整数之前,应如何调整其规模。仅在@ScaledNumberField上可用。要索引小数点后有有效数字的数字,请将

decimalScale设置为需要索引的数字位数。小数点将向右移动这些位数,然后进行索引,从而保留小数部分的这些位数。要索引无法容纳在长整型中的非常大的数字,请将小数点设置为负值。小数点将向左移动这些位数,然后进行索引,从而丢弃小数部分的所有位数。只有对于

BigDecimal才允许具有严格正值的decimalScale,因为BigInteger值没有小数位数。请注意,小数点的移动是完全透明的,不会影响您使用搜索 DSL 的方式:您需要提供“正常”的

BigDecimal或BigInteger值,Hibernate Search 将透明地应用decimalScale和舍入操作。由于舍入的影响,搜索谓词和排序的精度仅受

decimalScale允许的精度限制。请注意,舍入不会影响投影,投影将返回原始值,没有任何精度损失。

一个典型的用例是货币金额,小数位数为 2,因为小数点后通常只需要两位数。 通过Hibernate ORM 集成,默认的 decimalScale将自动从相关 SQL@Column的底层scale值中获取,使用 Hibernate ORM 元数据。可以使用decimalScale属性显式覆盖该值。 -

highlightable -

该字段是否可以突出显示,如果是,哪些突出显示器类型可以应用于该字段。即该字段值是否以特定格式索引/存储,以便在查询时允许稍后突出显示。仅在

@FullTextField上可用。虽然在大多数情况下选择一种突出显示器类型就足够了,但此属性可以接受多个不矛盾的值。请参考突出显示器类型部分以查看要选择哪个突出显示器。可用值为

值 定义 Highlightable.NOHighlightable.ANY允许对该字段进行突出显示时应用任何突出显示器类型。

Highlightable.PLAIN允许对该字段进行突出显示时应用纯文本突出显示器类型。

Highlightable.UNIFIEDHighlightable.FAST_VECTOR允许对该字段进行突出显示时应用快速向量突出显示器类型。此突出显示器类型需要将词向量存储策略设置为

WITH_POSITIONS_OFFSETS或WITH_POSITIONS_OFFSETS_PAYLOADS。Highlightable.DEFAULT使用特定于后端的默认值,该默认值取决于字段的整体配置。Elasticsearch的默认值为

[Highlightable.PLAIN, Highlightable.UNIFIED]。 Lucene的默认值取决于为该字段配置的可投影值。如果该字段是可投影的,则支持[PLAIN, UNIFIED]突出显示器。否则,不支持突出显示(Highlightable.NO)。此外,如果词向量存储策略设置为WITH_POSITIONS_OFFSETS或WITH_POSITIONS_OFFSETS_PAYLOADS,则这两个后端都将支持FAST_VECTOR突出显示器,如果它们已经支持另外两个([PLAIN, UNIFIED])。 -

dimension -

以下详细介绍的功能处于 孵化 状态:它们仍在积极开发中。

通常的 兼容性策略 不适用:孵化元素(例如类型、方法、配置属性等)的契约可能会在后续版本中以向后不兼容的方式更改(甚至被删除)。

建议您使用孵化功能,以便开发团队可以获得反馈并改进它们,但您应该准备好根据需要更新依赖于它们的代码。

存储向量的尺寸。这是必需字段。此尺寸应与用于将数据转换为向量表示的模型生成的向量尺寸匹配。它应该是一个正整数。最大允许值是特定于后端的。对于Lucene 后端,尺寸必须在

[1, 4096]范围内。至于Elasticsearch 后端,范围取决于分发版本。请参阅Elasticsearch/OpenSearch的特定文档,以了解这些分发版本的向量类型。仅在

@VectorField上可用。 -

vectorSimilarity -

以下详细介绍的功能处于 孵化 状态:它们仍在积极开发中。

通常的 兼容性策略 不适用:孵化元素(例如类型、方法、配置属性等)的契约可能会在后续版本中以向后不兼容的方式更改(甚至被删除)。

建议您使用孵化功能,以便开发团队可以获得反馈并改进它们,但您应该准备好根据需要更新依赖于它们的代码。

定义在向量搜索期间如何计算向量相似度。

仅在

@VectorField上可用。值 定义 VectorSimilarity.L2L2(欧几里得)范数,对于大多数情况来说都是合理的默认值。向量

x和y之间的距离计算为\(d(x,y) = \sqrt{\sum_{i=1}^{n} (x_i - y_i)^2 } \),得分函数为\(s = \frac{1}{1+d^2}\)VectorSimilarity.DOT_PRODUCT内积(特别是点积)。向量

x和y之间的距离计算为\(d(x,y) = \sum_{i=1}^{n} x_i \cdot y_i \),得分函数为\(s = \frac{1}{1+d}\)为了有效地使用此相似度,索引向量和搜索向量必须被归一化;否则,搜索可能会产生糟糕的结果。浮点向量必须归一化为单位长度,而字节向量应该只具有相同的范数。

VectorSimilarity.COSINE余弦相似度。向量

x和y之间的距离计算为\(d(x,y) = \frac{1 - \sum_{i=1} ^{n} x_i \cdot y_i }{ \sqrt{ \sum_{i=1} ^{n} x_i^2 } \sqrt{ \sum_{i=1} ^{n} y_i^2 }} \),得分函数为\(s = \frac{1}{1+d}\)VectorSimilarity.MAX_INNER_PRODUCT类似于点积相似度,但不需要向量归一化。向量

x和y之间的距离计算为\(d(x,y) = \sum_{i=1}^{n} x_i \cdot y_i \),得分函数为\(s = \begin{cases} \frac{1}{1-d} & \text{if d < 0}\\ d+1 & \text{otherwise} \end{cases} \)VectorSimilarity.DEFAULT使用特定于后端的默认值。对于Lucene 后端,使用

L2相似度。表 4. 向量相似度如何与特定于后端的价值观相匹配 Hibernate Search 值 Lucene 后端 Elasticsearch 后端 Elasticsearch 后端(OpenSearch 发行版) DEFAULTEUCLIDEANElasticsearch 默认值

OpenSearch 默认值。

L2EUCLIDEANl2_norml2DOT_PRODUCTDOT_PRODUCTdot_product目前不支持OpenSearch,并将导致异常。

COSINECOSINEcosinecosinesimilMAX_INNER_PRODUCTMAXIMUM_INNER_PRODUCTmax_inner_product目前不支持OpenSearch,并将导致异常。

-

efConstruction -

以下详细介绍的功能处于 孵化 状态:它们仍在积极开发中。

通常的 兼容性策略 不适用:孵化元素(例如类型、方法、配置属性等)的契约可能会在后续版本中以向后不兼容的方式更改(甚至被删除)。

建议您使用孵化功能,以便开发团队可以获得反馈并改进它们,但您应该准备好根据需要更新依赖于它们的代码。

efConstruction是 k-NN 图创建期间使用的动态列表的尺寸。它影响向量的存储方式。更高的值会导致更精确的图,但索引速度会更慢。默认值是特定于后端的。

仅在

@VectorField上可用。 -

m -

以下详细介绍的功能处于 孵化 状态:它们仍在积极开发中。

通常的 兼容性策略 不适用:孵化元素(例如类型、方法、配置属性等)的契约可能会在后续版本中以向后不兼容的方式更改(甚至被删除)。

建议您使用孵化功能,以便开发团队可以获得反馈并改进它们,但您应该准备好根据需要更新依赖于它们的代码。

每个节点在HNSW(分层可导航小世界图)图中连接到的邻居数量。修改此值会影响内存消耗。建议将此值保持在 2 到 100 之间。

默认值是特定于后端的。

仅在

@VectorField上可用。

10.5.4. 支持的属性类型

以下是列出所有具有内置值桥接的类型的表格,即在将属性映射到索引字段时开箱即用的支持的属性类型。

该表还解释了分配给索引字段的值,即传递给底层后端以进行索引的值。

|

有关底层后端使用的索引和存储的信息,请参阅Lucene 字段类型或Elasticsearch 字段类型,具体取决于您的后端。 |

| 属性类型 | 索引字段的值(如果不同) | 限制 | 查询字符串谓词中“indexNullAs”/terms 的解析方法 |

|---|---|---|---|

|

|

- |

|

|

- |

- |

- |

|

一个单字符 |

- |

接受任何单字符 |

|

- |

- |

|

|

- |

- |

|

|

- |

- |

|

|

- |

- |

|

|

- |

- |

|

|

- |

- |

|

|

- |

- |

接受字符串 |

|

- |

- |

|

|

- |

- |

|

|

|

- |

|

|

|

- |

|

|

- |

|

|

|

- |

|

|

|

- |

|

|

|

- |

|

|

|

- |

|

|

|

- |

|

|

|

- |

|

|

|

|

- |

|

|

|

- |

|

|

格式化的 |

- |

|

|

|

|

|

|

- |

|

|

|

- |

|

|

|

- |

- |

|

|

|

- |

|

|

表示相同日期/时间和时区的 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

- |

- |

纬度为双精度,经度为双精度,用逗号隔开。例如: |

|

日期/时间字段的范围和分辨率

除了少数例外,大多数日期和时间值按原样传递给后端;例如, 但是,在内部,Lucene 和 Elasticsearch 后端使用不同的日期/时间类型表示形式。因此,存储在索引中的日期和时间字段的范围和分辨率可能小于相应的 Java 类型。 每个后端的文档提供了更多信息:请参阅Lucene 的信息和Elasticsearch 的信息。 |

10.5.5. 对传统java.util日期/时间 API 的支持

不建议使用过时的日期/时间类型,例如java.util.Calendar、java.util.Date、java.sql.Timestamp、java.sql.Date、java.sql.Time,因为它们存在许多奇特之处和缺陷。Java 8 中引入的java.time包通常更受欢迎。

话虽如此,集成约束可能会迫使您依赖过时的日期/时间 API,这就是 Hibernate Search 仍然尽力支持它们的原因。

由于 Hibernate Search 使用java.time API 在内部表示日期/时间,因此在对过时的日期/时间类型进行索引之前需要对其进行转换。Hibernate Search 将操作简化:java.util.Date、java.util.Calendar 等将使用它们的时间值(自纪元以来的毫秒数)进行转换,该值将被假定为在 Java 8 API 中表示相同的日期/时间。在java.util.Calendar的情况下,时区信息将被保留以供投影使用。

对于 1900 年之后的所有日期,这将按预期工作。

在 1900 年之前,通过 Hibernate Search API 进行索引和搜索也将按预期工作,但**如果您需要以原生方式访问索引**,例如通过对 Elasticsearch 服务器的直接 HTTP 调用,您会注意到索引的值略有“偏差”。这是由于java.time 和过时的日期/时间 API 的实现方式不同,导致对时间值(自纪元以来的毫秒数)的解释略有差异。

这种“偏差”是一致的:在构建谓词时也会发生,并且在投影时会发生在相反的方向。因此,对于仅依赖 Hibernate Search API 的应用程序来说,这些差异将不可见。但是,在以原生方式访问索引时,它们将是可见的。

对于绝大多数用例,这将不是问题。如果这种行为对于您的应用程序不可接受,您应该考虑实现自定义值桥,并指示 Hibernate Search 为java.util.Date、java.util.Calendar 等默认使用它们:请参见使用桥解析器分配默认桥.

|

从技术上讲,转换很困难,因为 特别是

这是两个主要问题,但可能还存在其他问题。 |

10.5.6. 映射自定义属性类型

即使是不支持开箱即用的类型也可以进行映射。有各种解决方案,一些很简单,另一些更强大,但它们都归结为从不支持的类型中提取数据并将其转换为后端支持的类型。

有两种情况需要区分

-

如果不支持的类型仅仅是一个容器(

List<String>)或多个嵌套容器(Map<Integer, List<String>>),其元素具有支持的类型,那么您需要的是一个容器提取器。有关更多信息,请参见使用容器提取器映射容器类型. -

否则,您将不得不依靠一个称为桥的自定义组件来从您的类型中提取数据。有关自定义桥的更多信息,请参见绑定和桥.

10.5.7. 编程映射

您也可以通过编程映射将实体的属性直接映射到索引字段。行为和选项与基于注释的映射相同。

.genericField()、.fullTextField() 等将属性直接映射到字段TypeMappingStep bookMapping = mapping.type( Book.class );

bookMapping.indexed();

bookMapping.property( "title" )

.fullTextField()

.analyzer( "english" ).projectable( Projectable.YES )

.keywordField( "title_sort" )

.normalizer( "english" ).sortable( Sortable.YES );

bookMapping.property( "pageCount" )

.genericField().projectable( Projectable.YES ).sortable( Sortable.YES );10.6. 使用@IndexedEmbedded映射关联元素

10.6.1. 基础

仅使用@Indexed 与@*Field 注释结合使用可以索引实体及其直接属性,这很好,但很简单。一个现实世界的模型将包含多个对象类型,它们相互引用,例如下面示例中的authors 关联。

此映射将在Book 索引中声明以下字段

-

title -

… 以及其他任何东西。

@Entity

@Indexed (1)

public class Book {

@Id

private Integer id;

@FullTextField(analyzer = "english") (2)

private String title;

@ManyToMany

private List<Author> authors = new ArrayList<>(); (3)

public Book() {

}

// Getters and setters

// ...

}@Entity

public class Author {

@Id

private Integer id;

private String name;

@ManyToMany(mappedBy = "authors")

private List<Book> books = new ArrayList<>();

public Author() {

}

// Getters and setters

// ...

}| 1 | Book 实体被索引。 |

| 2 | 书籍的title 被映射到一个索引字段。 |

| 3 | 但是如何将Author 名字索引到Book 索引中呢? |

在搜索书籍时,用户可能需要按作者姓名进行搜索。在高性能索引的世界中,跨索引连接代价高昂,通常不可取。解决此类用例的最佳方法通常是复制数据:在索引Book 时,只需将所有作者的姓名复制到Book 文档中。

这就是@IndexedEmbedded 的作用:它指示 Hibernate Search 将关联对象的字段嵌入到主对象中。在下面的示例中,它将指示 Hibernate Search 将Author 中定义的name 字段嵌入到Book 中,从而创建字段authors.name。

|

|

@IndexedEmbedded 索引关联元素此映射将在Book 索引中声明以下字段

-

title -

authors.name

@Entity

@Indexed

public class Book {

@Id

private Integer id;

@FullTextField(analyzer = "english")

private String title;

@ManyToMany

@IndexedEmbedded (1)

private List<Author> authors = new ArrayList<>();

public Book() {

}

// Getters and setters

// ...

}@Entity

public class Author {

@Id

private Integer id;

@FullTextField(analyzer = "name") (2)

private String name;

@ManyToMany(mappedBy = "authors")

private List<Book> books = new ArrayList<>();

public Author() {

}

// Getters and setters

// ...

}| 1 | 在authors 属性中添加一个@IndexedEmbedded。 |

| 2 | 将Author.name 映射到一个索引字段,即使Author 没有直接映射到一个索引(没有@Indexed)。 |

|

文档标识符 不是索引字段。因此,它们将被 要使用 |

|

当 有关此限制的原因以及解决方法,请参见嵌入元素发生更改时的重新索引. |

索引嵌入可以在多个级别上嵌套;例如,您可以决定索引嵌入作者的出生地点,以便能够专门搜索由俄罗斯作者撰写的书籍

@IndexedEmbedded此映射将在Book 索引中声明以下字段

-

title -

authors.name -

authors.placeOfBirth.country

@Entity

@Indexed

public class Book {

@Id

private Integer id;

@FullTextField(analyzer = "english")

private String title;

@ManyToMany

@IndexedEmbedded (1)

private List<Author> authors = new ArrayList<>();

public Book() {

}

// Getters and setters

// ...

}@Entity

public class Author {

@Id

private Integer id;

@FullTextField(analyzer = "name") (2)

private String name;

@Embedded

@IndexedEmbedded (3)

private Address placeOfBirth;

@ManyToMany(mappedBy = "authors")

private List<Book> books = new ArrayList<>();

public Author() {

}

// Getters and setters

// ...

}@Embeddable

public class Address {

@FullTextField(analyzer = "name") (4)

private String country;

private String city;

private String street;

public Address() {

}

// Getters and setters

// ...

}| 1 | 在authors 属性中添加一个@IndexedEmbedded。 |

| 2 | 将Author.name 映射到一个索引字段,即使Author 没有直接映射到一个索引(没有@Indexed)。 |

| 3 | 在placeOfBirth 属性中添加一个@IndexedEmbedded。 |

| 4 | 将Address.country 映射到一个索引字段,即使Address 没有直接映射到一个索引(没有@Indexed)。 |

|

默认情况下, 要解决此问题,请参见过滤嵌入字段并打破 |

10.6.2. @IndexedEmbedded 和null 值

当@IndexedEmbedded 目标的属性包含null 元素时,这些元素将简单地不被索引。

与使用@GenericField、@FullTextField 等将属性映射到索引字段不同,没有indexNullAs 功能来为null 对象索引特定值,但您可以利用搜索查询中的exists 谓词来查找给定@IndexedEmbedded 有或没有值的文档:只需将对象字段的名称传递给exists 谓词,例如上面的示例中的authors。

10.6.3. 容器类型上的@IndexedEmbedded

当@IndexedEmbedded 目标的属性具有容器类型(List、Optional、Map 等)时,将嵌入最里面的元素。例如,对于类型为List<MyEntity> 的属性,将嵌入类型为MyEntity 的元素。

本节描述了此默认行为以及覆盖它的方法: 使用容器提取器映射容器类型。

10.6.4. 使用name 设置对象字段名称

默认情况下,@IndexedEmbedded 将使用与注释属性相同的名称创建一个对象字段,并将嵌入字段添加到该对象字段中。因此,如果@IndexedEmbedded 应用于Book 实体中名为authors 的属性,则在索引Book 时,作者的索引字段name 将被复制到索引字段authors.name 中。

可以通过设置name 属性来更改对象字段的名称;例如,在上面的示例中使用@IndexedEmbedded(name = "allAuthors") 将导致作者的姓名被复制到索引字段allAuthors.name 中,而不是authors.name 中。

|

名称不能包含点字符( |

10.6.5. 使用prefix 设置字段名称前缀

|

|

默认情况下,@IndexedEmbedded 将在嵌入字段的名称前加上它所应用的属性的名称,后跟一个点。因此,如果@IndexedEmbedded 应用于Book 实体中名为authors 的属性,则在索引Book 时,作者的name 字段将被复制到authors.name 字段中。

可以通过设置prefix 属性来更改此前缀,例如@IndexedEmbedded(prefix = "author.")(不要忘记尾部的点!)。

|